这是一个非常硬核且实用的技术架构文档,主要解决了 SpringBoot 应用在生产环境中Web 容器(Tomcat/Jetty)线程池无法动态调整的痛点。

考虑到内容涉及原理机制、架构设计、源码实现三个层面,为了让你彻底通透地理解,我将内容拆解为三篇进行详细讲解。

这是第一篇,我们将聚焦于核心痛点、请求处理链路以及 Tomcat 与 Jetty 线程池的底层差异。

第一篇:核心背景与 Web 容器线程池底层原理

1. 为什么我们需要动态调整 Web 线程池?

1.1 痛点场景复现

文档开篇提到的场景非常经典:

大促期间,订单服务超时,CPU/DB 正常,但请求在排队。

原因分析:

SpringBoot 内置的 Tomcat 默认最大线程数通常是 200(server.tomcat.threads.max)。

- 平时: 流量小,200 个线程绰绰有余。

- 大促: 流量瞬间爆发(如 QPS 从 100 飙升到 2000),200 个线程处理不过来,后续请求只能在队列里等待,甚至超时报错。

传统解决尴尬:

- 改配置重启: 修改

application.yml-> 重启服务。- 代价: 服务中断,重启期间流量丢失,甚至引起集群雪崩。

- 预设过大: 平时就开 1000 个线程。

- 代价: 浪费内存,上下文切换(Context Switch)开销大,CPU 虚高。

结论: 我们需要像“调节音量”一样,在服务运行时动态修改线程池参数。

1.2 Web 容器线程池在链路中的位置

SpringBoot Web 容器线程池是 Web 服务器(如Tomcat、Jetty、Undertow)用来处理 HTTP 请求的核心线程池。当客户端发起 HTTP 请求时,Web 容器会从线程池中分配一个工作线程来处理这个请求,包括解析 HTTP 协议、调用 SpringMVC 控制器、返回响应等全过程。

Web 容器线程池是流量的“第一道阀门”。

- 连接器(Connector): 接收 TCP 连接。

- 线程池(核心瓶颈): 这里是 HTTP 解析和Servlet 调用的起点。

- 如果这里堵了,后续的 Controller、Service、DB 性能再好也没用,因为请求根本进不来。

- 业务逻辑: 才是我们平时写的

@RequestMapping代码。

在传统的 SpringBoot 应用中,Web 容器线程池的配置通常通过 application.yml 文件进行:

server:tomcat:

threads:

max: 200 # 最大线程数

min-spare: 10 # 最小空闲线程数

accept-count: 100 # 队列容量

max-connections:8192# 最大连接数2. 深度解析:Tomcat 与 Jetty 的线程池差异

这是实现动态调参最难的地方,因为 SpringBoot 屏蔽了底层细节,但 oneThread 必须穿透屏蔽层去操作底层。

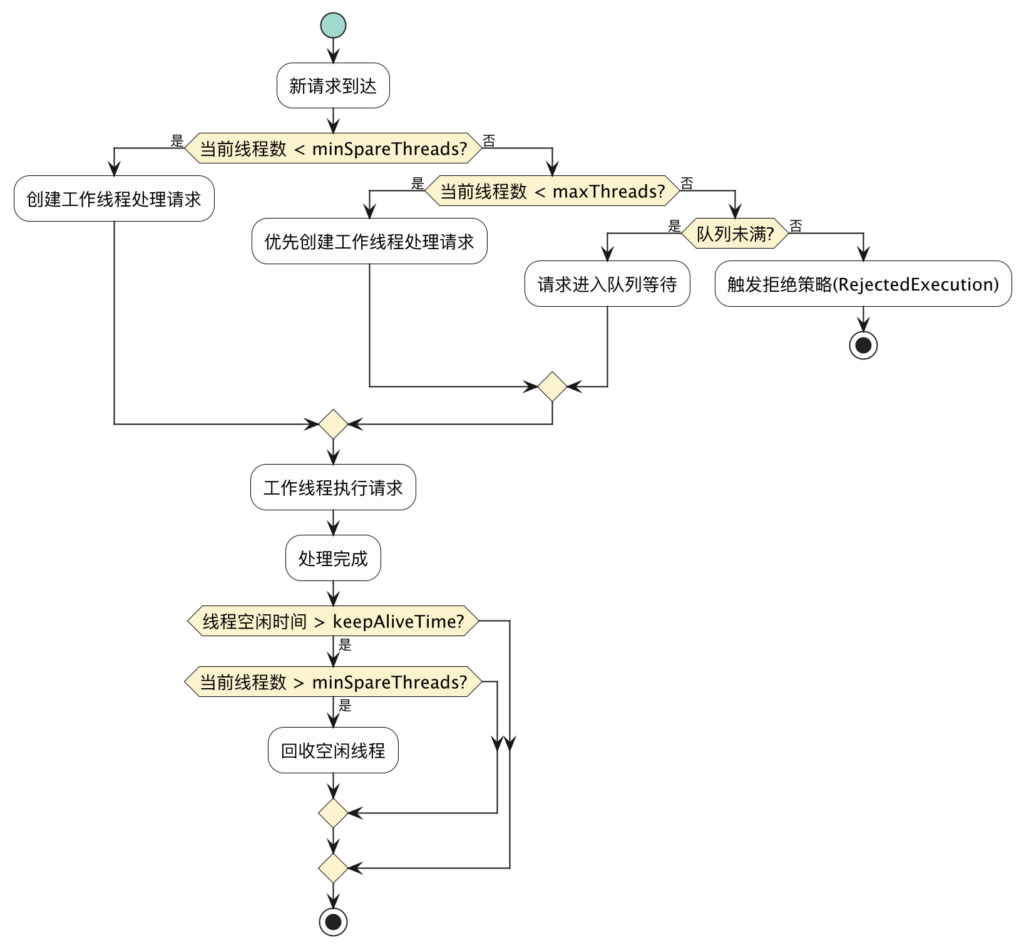

2.1 Tomcat 线程池原理(“急脾气”策略)

Tomcat 使用的是扩展自 JDK ThreadPoolExecutor 的实现,但它修改了核心逻辑。

JDK 标准线程池逻辑:

核心线程满 -> 先入队列 -> 队列满 -> 才创建新线程(直到最大值)。

- 缺点: 只有队列满了才会通过增加线程来救火,响应偏慢。

Tomcat 线程池逻辑(StandardThreadExecutor):

核心线程满 -> 先创建新线程(直到最大值) -> 线程满 -> 才入队列。

- 优点: 面对突发流量,优先拉起人手(线程)干活,尽量不让请求排队。

Tomcat 通过自定义 TaskQueue 实现了这一逻辑。当它发现当前线程数 < 最大线程数时,会欺骗 JDK 线程池说“队列满了”,迫使 JDK 创建新线程

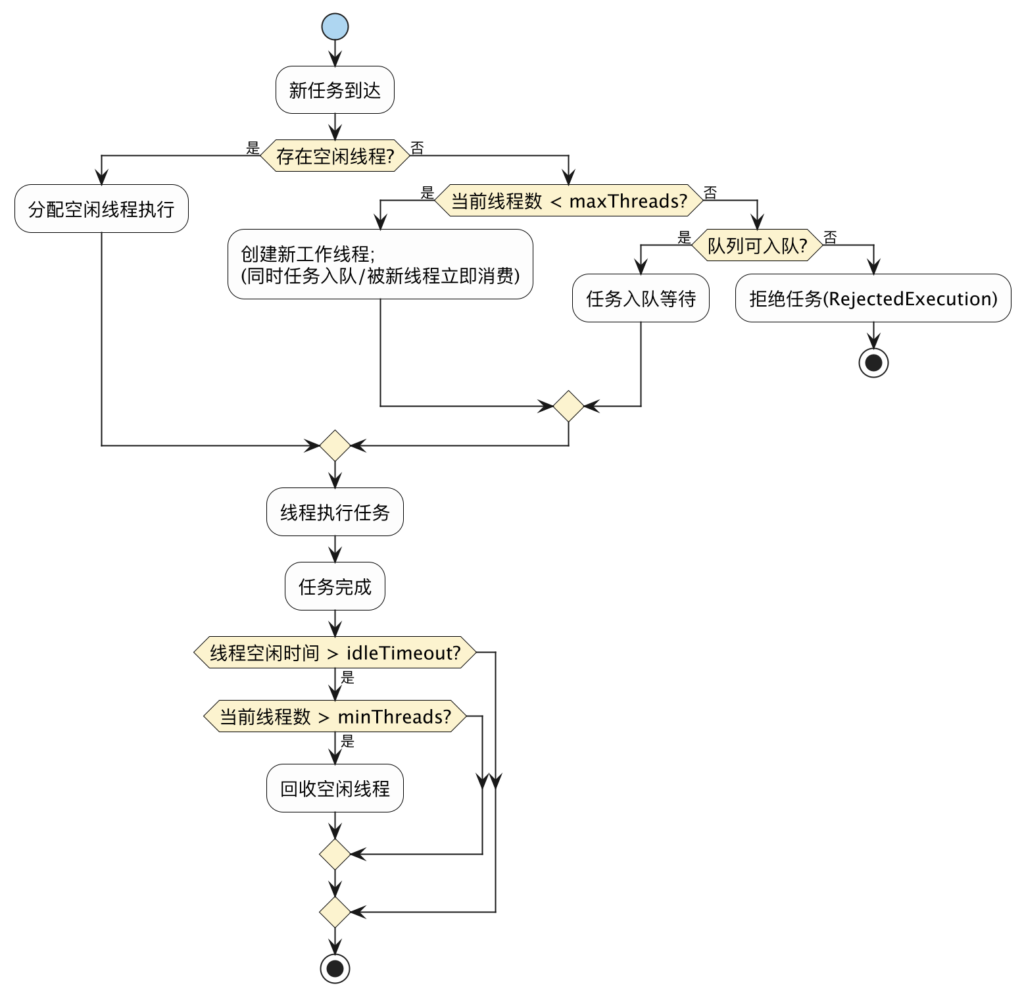

2.2 Jetty 线程池原理(“大锅饭”策略)

Jetty 没有用 JDK 的 ThreadPoolExecutor,而是自己造了个轮子叫 QueuedThreadPool:线程池中的线程循环永远只从 _jobs 队列中取任务。

核心机制:

- 生产者-消费者模型: 所有任务(HTTP 请求)无差别地放入一个公共队列

_jobs。避免了“直接 handoff 给线程”带来的并发复杂度(比如直接提交任务到特定线程需要更多同步逻辑)。 - 抢占式执行: 所有的线程(无论是空闲的还是新启动的)都死循环地从这个

_jobs队列里抢任务做。采用传统的"先排队后扩容"策略,这在某些场景下可能导致响应延迟。

与 Tomcat 的区别:

- 参数名不同: Tomcat 叫

corePoolSize/maxPoolSize,Jetty 叫minThreads/maxThreads。 - 单位不同: 空闲超时

idleTimeout,Jetty 用毫秒,Tomcat (JDK) 通常用秒。 - API 封闭: Jetty 的内部队列

_jobs是私有的,普通 API 拿不到,后续需要用反射暴力获取。

3. 第一篇总结与思考

在进入代码实现之前,我们需要明确:

- 目标: 实现一套代码,同时兼容 Tomcat 和 Jetty。

- 难点:

- 如何拿到 SpringBoot 启动后的那个

WebServer实例? - 如何抹平 Tomcat

ThreadPoolExecutor和 JettyQueuedThreadPool的 API 差异(比如 setCorePoolSize vs setMinThreads)? - 如何在调整参数时不报错(比如核心线程数不能大于最大线程数)?

- 如何拿到 SpringBoot 启动后的那个

oneThread 的解决方案是: 采用适配器模式(Adapter Pattern) + Spring 条件装配。

下一篇预告:架构设计与自动装配

接下来我将讲解 oneThread 是如何利用 SpringBoot 的 @Conditional 魔法自动识别你用的是 Tomcat 还是 Jetty,以及如何通过统一的接口层 WebThreadPoolService 屏蔽底层差异。

好的,我们进入第二篇:架构设计与自动装配魔法。

在上一篇中,我们搞清楚了 Tomcat 和 Jetty 像两个性格迥异的“工人”(底层原理不同)。这一篇,我们要讲解 oneThread 框架是如何充当“包工头”的角色,把这两个性格迥异的工人管理起来,让上层业务感觉不到差异的。

第二篇:架构设计与统一抽象

1. 整体架构:分层设计的智慧

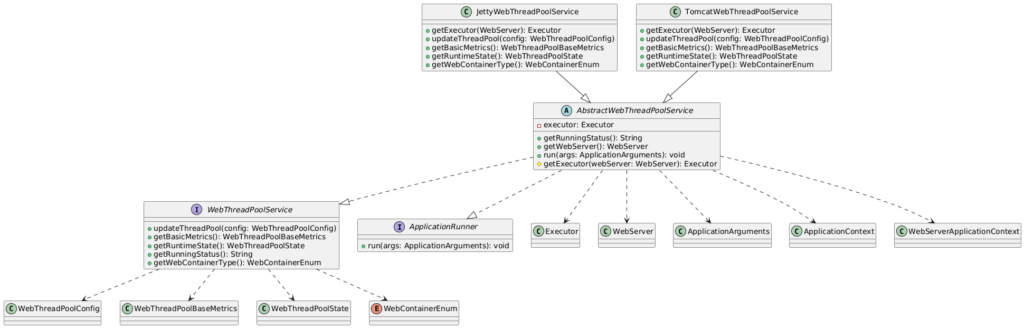

请看文档中的UML 类图(第二张图),这是一个典型的适配器模式(Adapter Pattern) 落地实践。

架构可以分为三层:

- 配置层 (Configuration Layer):

WebAdapterConfiguration:这是入口。它负责侦探工作,判断当前环境里到底是谁在干活(Tomcat 还是 Jetty?),然后把对应的管理服务加载进来。

- 抽象层 (Abstraction Layer):

WebThreadPoolService(接口) &AbstractWebThreadPoolService(抽象类):制定“家规”。不管你是谁,都要能汇报状态(RuntimeState),都要能调整参数(updateThreadPool)。

- 实现层 (Implementation Layer):

TomcatWebThreadPoolService:懂 Tomcat 的“方言”,负责翻译指令。JettyWebThreadPoolService:懂 Jetty 的“方言”,负责翻译指令。

2. 核心魔法:Spring Boot 条件装配

很多同学看开源框架源码,最容易晕的就是:“为什么他引入了那么多依赖,运行起来却不报错?”

oneThread 同时支持 Tomcat、Jetty、Undertow,但在你的项目中,你可能只用了 Tomcat。如果代码里直接 new JettyWebThreadPoolService(),JVM 马上就会抛出 ClassNotFoundException,因为你的 classpath 下根本没有 Jetty 的 jar 包。

解决方案:@Conditional 系列注解

oneThread 使用 SpringBoot 的条件装配机制来实现多容器的自动适配;让我们剖析文档中的这段核心代码:

@Bean

@ConditionalOnClass(name = {

"org.apache.catalina.startup.Tomcat",

"org.apache.coyote.UpgradeProtocol",

"jakarta.servlet.Servlet"

})

@ConditionalOnBean(value = ConfigurableTomcatWebServerFactory.class, search = SearchStrategy.CURRENT)

public TomcatWebThreadPoolService tomcatWebThreadPoolService() {

return new TomcatWebThreadPoolService();

}这里有两道防线确保安全:

- 第一道防线

@ConditionalOnClass(类存在吗?):- Spring 会先检查:

org.apache.catalina.startup.Tomcat这个类在不在? - 如果你没引入

spring-boot-starter-tomcat,这个类就不存在。Spring 直接跳过这个 Bean 的创建,JVM 就不会去加载TomcatWebThreadPoolService,从而避免报错。

- Spring 会先检查:

- 第二道防线

@ConditionalOnBean(实例存在吗?):- 防止虽然有 jar 包,但是用户手动关闭了 Web 功能(比如跑跑批任务)。

- 只有 Spring 容器里真正跑起来了

ConfigurableTomcatWebServerFactory,说明真的是个 Web 环境,才创建服务。

Maven 依赖管理的技巧:

文档中提到的 <optional>true</optional> 非常关键。

oneThread编译时:我有 Tomcat 和 Jetty 的 jar 包,所以代码能编译通过。你的项目引用oneThread时:Maven 看到optional,就不会把 Tomcat/Jetty 的依赖传递给你。你原本用什么,就是什么,保持了项目的纯净。

3. 统一抽象:制定“普通话”

底层差异这么大,必须强制统一接口。WebThreadPoolService 接口就是“普通话”。

public interface WebThreadPoolService {

// 你的项目只管调这个方法,不用管底层是 setCorePoolSize 还是 setMinThreads

void updateThreadPool(WebThreadPoolConfig config);

// 统一返回这个对象,不管底层指标叫什

// 获取基础指标(轻量级,适合高频调用)

WebThreadPoolBaseMetrics getBasicMetrics();

// 获取完整运行状态(可能涉及锁,不建议高频调用)

WebThreadPoolState getRuntimeState();

// 获取运行状态描述

String getRunningStatus();

// 获取容器类型

WebContainerEnum getWebContainerType();

}设计哲学:

- 上层调用无感: 当你需要修改线程池时,你只需要构建一个

WebThreadPoolConfig对象,里面包含通用的corePoolSize,maxPoolSize。 - 下层负责翻译: 具体的 Service 实现类负责把这些通用参数,转换成底层容器能听懂的指令。

4. 抽丝剥茧:如何拿到底层的线程池对象?

这是本篇最精彩的源码挖掘部分。Spring Boot 封装得太好了,导致我们很难拿到最里面的 ThreadPoolExecutor。

我们需要像“剥洋葱”一样一层层剥开 Spring 的封装。

4.1 Tomcat 的“洋葱结构”

在 TomcatWebThreadPoolService 中,获取线程池的路径是这样的:

@Override

protected Executor getExecutor(WebServer webServer) {

return

// 入口是 Spring 的 WebServer 接口

((TomcatWebServer) webServer) // 1. 强转为 TomcatWebServer (Spring 的封装)

.getTomcat() // 2. 获取 Tomcat 实例 (org.apache.catalina.startup.Tomcat)

.getConnector() // 3. 获取连接器 (处理端口连接的)

.getProtocolHandler() // 4. 获取协议处理器 (处理 HTTP/AJP 协议的)

.getExecutor(); // 5. 终于拿到了 java.util.concurrent.Executor !

}拿到这个 Executor 后,我们就可以把它强转为 ThreadPoolExecutor,然后就可以随心所欲地调用 setCorePoolSize 了。

在动态调整 Tomcat 线程池参数时,需要特别注意参数更新的顺序,避免出现配置冲突:

@Override public void updateThreadPool(WebThreadPoolConfig config) { try { ThreadPoolExecutor tomcatExecutor = (ThreadPoolExecutor) executor; int originalCorePoolSize = tomcatExecutor.getCorePoolSize(); int originalMaximumPoolSize = tomcatExecutor.getMaximumPoolSize(); long originalKeepAliveTime = tomcatExecutor.getKeepAliveTime(TimeUnit.SECONDS); // 关键:参数更新顺序很重要 if (config.getCorePoolSize() > originalMaximumPoolSize) { // 如果新的核心线程数大于当前最大线程数,先调整最大线程数 tomcatExecutor.setMaximumPoolSize(config.getMaximumPoolSize()); tomcatExecutor.setCorePoolSize(config.getCorePoolSize()); } else { // 否则先调整核心线程数 tomcatExecutor.setCorePoolSize(config.getCorePoolSize()); tomcatExecutor.setMaximumPoolSize(config.getMaximumPoolSize()); } tomcatExecutor.setKeepAliveTime(config.getKeepAliveTime(), TimeUnit.SECONDS); log.info("[Tomcat] Changed web thread pool. corePoolSize: {}, maximumPoolSize: {}, keepAliveTime: {}", String.format(Constants.CHANGE_DELIMITER, originalCorePoolSize, config.getCorePoolSize()), String.format(Constants.CHANGE_DELIMITER, originalMaximumPoolSize, config.getMaximumPoolSize()), String.format(Constants.CHANGE_DELIMITER, originalKeepAliveTime, config.getKeepAliveTime())); } catch (Exception ex) { log.error("Failed to modify the Tomcat thread pool parameter.", ex); } }ThreadPoolExecutor有一个重要的约束:核心线程数不能大于最大线程数 。这里前面已经讲解过,就不再赘述。

3. Tomcat 线程池监控指标获取

Tomcat 基于标准的 ThreadPoolExecutor,因此可以获取到丰富的运行时指标:

@Override public WebThreadPoolState getRuntimeState() { ThreadPoolExecutor tomcatExecutor = (ThreadPoolExecutor) executor; // 基础配置参数 int corePoolSize = tomcatExecutor.getCorePoolSize(); int maximumPoolSize = tomcatExecutor.getMaximumPoolSize(); long keepAliveTime = tomcatExecutor.getKeepAliveTime(TimeUnit.SECONDS); // 运行时状态指标 int activeCount = tomcatExecutor.getActiveCount(); // 当前活跃线程数 long completedTaskCount = tomcatExecutor.getCompletedTaskCount(); // 已完成任务数 int largestPoolSize = tomcatExecutor.getLargestPoolSize(); // 历史最大线程数 int currentPoolSize = tomcatExecutor.getPoolSize(); // 当前线程数 // 队列相关指标 BlockingQueue<?> blockingQueue = tomcatExecutor.getQueue(); int blockingQueueSize = blockingQueue.size(); // 队列中等待的任务数 int remainingCapacity = blockingQueue.remainingCapacity(); // 队列剩余容量 int queueCapacity = blockingQueueSize + remainingCapacity; // 队列总容量 // 拒绝策略 String rejectedExecutionHandlerName = tomcatExecutor .getRejectedExecutionHandler() .getClass() .getSimpleName(); return WebThreadPoolState.builder() .corePoolSize(corePoolSize) .maximumPoolSize(maximumPoolSize) .activePoolSize(activeCount) .completedTaskCount(completedTaskCount) .largestPoolSize(largestPoolSize) .currentPoolSize(currentPoolSize) .keepAliveTime(keepAliveTime) .workQueueName(blockingQueue.getClass().getSimpleName()) .workQueueSize(blockingQueueSize) .workQueueRemainingCapacity(remainingCapacity) .workQueueCapacity(queueCapacity) .rejectedHandlerName(rejectedExecutionHandlerName) .build(); }

4.2 Jetty 的“洋葱结构”

Jetty 稍微简单一点,但也需要转换:

((JettyWebServer) webServer) // 1. 强转为 JettyWebServer

.getServer() // 2. 获取 Jetty Server 核心对象

.getThreadPool(); // 3. 获取 org.eclipse.jetty.util.thread.ThreadPool拿到 ThreadPool 后,强转为 QueuedThreadPool,就可以调用 setMinThreads 等 Jetty 特有的 API 了。

1Jetty 参数更新实现

@Override public void updateThreadPool(WebThreadPoolConfig config) { try { QueuedThreadPool jettyExecutor = (QueuedThreadPool) executor; int originalCorePoolSize = jettyExecutor.getMinThreads(); int originalMaximumPoolSize = jettyExecutor.getMaxThreads(); long originalKeepAliveTime = jettyExecutor.getIdleTimeout(); // Jetty也需要注意参数更新顺序 if (config.getCorePoolSize() > originalMaximumPoolSize) { jettyExecutor.setMaxThreads(config.getMaximumPoolSize()); jettyExecutor.setMinThreads(config.getCorePoolSize()); } else { jettyExecutor.setMinThreads(config.getCorePoolSize()); jettyExecutor.setMaxThreads(config.getMaximumPoolSize()); } // 注意:Jetty的idleTimeout使用毫秒单位,需要转换 jettyExecutor.setIdleTimeout(config.getKeepAliveTime().intValue()); log.info("[Jetty] Changed web thread pool. corePoolSize: {}, maximumPoolSize: {}, keepAliveTime: {}", String.format(Constants.CHANGE_DELIMITER, originalCorePoolSize, config.getCorePoolSize()), String.format(Constants.CHANGE_DELIMITER, originalMaximumPoolSize, config.getMaximumPoolSize()), String.format(Constants.CHANGE_DELIMITER, originalKeepAliveTime, config.getKeepAliveTime())); } catch (Exception ex) { log.error("Failed to modify the Jetty thread pool parameter.", ex); } }Jetty参数调整的注意事项 :

- 1.方法名映射 :

setCorePoolSize()→setMinThreads()setMaximumPoolSize()→setMaxThreads()setKeepAliveTime()→setIdleTimeout()- 2.时间单位转换 :Jetty 的

idleTimeout使用毫秒,而我们的配置使用秒,需要进行单位转换。- 3.参数约束 :Jetty 同样有

minThreads <= maxThreads的约束,需要注意更新顺序。3. Jetty 队列信息获取的特殊处理

由于Jetty的队列对象是私有字段,需要通过反射来获取:

@SneakyThrows @Override public WebThreadPoolBaseMetrics getBasicMetrics() { QueuedThreadPool jettyExecutor = (QueuedThreadPool) executor; int corePoolSize = jettyExecutor.getMinThreads(); int maximumPoolSize = jettyExecutor.getMaxThreads(); long keepAliveTime = jettyExecutor.getIdleTimeout(); // 通过反射获取私有的_jobs队列 BlockingQueue jobs = (BlockingQueue) ReflectUtil.getFieldValue(jettyExecutor, "_jobs"); int blockingQueueSize = jettyExecutor.getQueueSize(); int remainingCapacity = jobs.remainingCapacity(); int queueCapacity = blockingQueueSize + remainingCapacity; // Jetty 没有标准的拒绝策略,使用固定名称 String rejectedExecutionHandlerName = "JettyRejectedExecutionHandler"; return WebThreadPoolBaseMetrics.builder() .corePoolSize(corePoolSize) .maximumPoolSize(maximumPoolSize) .keepAliveTime(keepAliveTime) .workQueueName(jobs.getClass().getSimpleName()) .workQueueSize(blockingQueueSize) .workQueueRemainingCapacity(remainingCapacity) .workQueueCapacity(queueCapacity) .rejectedHandlerName(rejectedExecutionHandlerName) .build(); }4. Jetty 运行状态的局限性

由于 Jetty 线程池设计的差异,某些 ThreadPoolExecutor 提供的指标在Jetty中无法获取:

@Override public WebThreadPoolState getRuntimeState() { QueuedThreadPool jettyExecutor = (QueuedThreadPool) executor; int corePoolSize = jettyExecutor.getMinThreads(); int maximumPoolSize = jettyExecutor.getMaxThreads(); int activeCount = jettyExecutor.getBusyThreads(); // 对应activeCount int currentPoolSize = jettyExecutor.getThreads(); // 对应currentPoolSize long keepAliveTime = jettyExecutor.getIdleTimeout(); BlockingQueue jobs = (BlockingQueue) ReflectUtil.getFieldValue(jettyExecutor, "_jobs"); int blockingQueueSize = jettyExecutor.getQueueSize(); int remainingCapacity = jobs.remainingCapacity(); int queueCapacity = blockingQueueSize + remainingCapacity; String rejectedExecutionHandlerName = "JettyRejectedExecutionHandler"; // 注意:Jetty无法提供completedTaskCount和largestPoolSize return WebThreadPoolState.builder() .corePoolSize(corePoolSize) .maximumPoolSize(maximumPoolSize) .activePoolSize(activeCount) .currentPoolSize(currentPoolSize) .keepAliveTime(keepAliveTime) .workQueueName(jobs.getClass().getSimpleName()) .workQueueSize(blockingQueueSize) .workQueueRemainingCapacity(remainingCapacity) .workQueueCapacity(queueCapacity) .rejectedHandlerName(rejectedExecutionHandlerName) // completedTaskCount和largestPoolSize在Jetty中不可用,设为默认值 .completedTaskCount(0L) .largestPoolSize(0) .build(); }这种局限性在设计监控系统时需要特别注意,不能假设所有容器都能提供相同的指标。

5. 第二篇总结

到这里,我们已经搭建好了舞台:

- 找到了人:通过 Spring 源码分析,我们从深层挖出了

Executor实例。 - 选对了人:通过

@Conditional,自动识别当前是 Tomcat 还是 Jetty 环境。 - 统一了语言:通过

WebThreadPoolService接口,屏蔽了底层 API 的差异。

还没解决的问题(伏笔):

虽然我们拿到了线程池对象,也能调用 set 方法了,但是直接调用安全吗?

- 如果我把核心线程数设得比最大线程数还大,Tomcat 会报错吗?

- Jetty 的队列是私有的,怎么监控它的队列长度?

- 监控数据如何实时获取?

下一篇预告:安全调参策略与黑科技监控

这是最后一篇,也是最实战的一篇。我们将深入代码细节,讲解如何防止参数更新导致的报错,以及如何利用反射去偷窥 Jetty 的私有队列状态。

好,我们进入第三篇(终篇):安全调参策略与黑科技监控。

在前两篇中,我们搞懂了原理,也拿到了底层的控制权。现在,我们要面对最棘手的实战细节:如何在“高速公路上换轮胎”(运行时修改参数)而不翻车?以及如何窥探 Jetty 那“封闭”的内心?

第三篇:实战细节与黑科技实现

1. 安全调参策略:解开“鸡生蛋,蛋生鸡”的死锁

在修改线程池参数时,Java 的 ThreadPoolExecutor 有一个硬性规定(Invariants):

核心线程数 (Core) 必须 小于等于 最大线程数 (Max)

如果不遵守这个规则,直接调用 set 方法,代码会抛出 IllegalArgumentException,导致你的调参失败。

1.1 场景推演:扩容与缩容的陷阱

假设当前配置:Core = 10, Max = 20。

场景 A:我要扩容(应对大促)

- 目标:Core = 50, Max = 100。

- 错误操作: 先设置

setCorePoolSize(50)。- 结果: 崩了!因为此时 Max 还是 20,50 > 20,违反规则。

- 正确操作:先扩 Max,再扩 Core。

setMaximumPoolSize(100)(此时 Core=10, Max=100,合法)setCorePoolSize(50)(此时 Core=50, Max=100,合法)

场景 B:我要缩容(大促结束)

- 当前状态:Core = 50, Max = 100。

- 目标:Core = 10, Max = 20。

- 错误操作: 先设置

setMaximumPoolSize(20)。- 结果: 崩了!因为此时 Core 还是 50,50 > 20,违反规则。

- 正确操作:先缩 Core,再缩 Max。

setCorePoolSize(10)(此时 Core=10, Max=100,合法)setMaximumPoolSize(20)(此时 Core=10, Max=20,合法)

1.2 代码实现的艺术

文档中的 TomcatWebThreadPoolService.updateThreadPool 方法完美地实现了这个逻辑:

// 这是一个非常经典的防坑逻辑

if (config.getCorePoolSize() > originalMaximumPoolSize) {

// 1. 如果新的核心数 > 旧的最大数,说明是大步扩容,必须先拉高天花板(Max)

tomcatExecutor.setMaximumPoolSize(config.getMaximumPoolSize());

tomcatExecutor.setCorePoolSize(config.getCorePoolSize());

} else {

// 2. 其他情况(包括缩容,或者小幅扩容),先调整核心数比较安全

tomcatExecutor.setCorePoolSize(config.getCorePoolSize());

tomcatExecutor.setMaximumPoolSize(config.getMaximumPoolSize());

}Jetty 的注意事项:

Jetty 的 QueuedThreadPool 同样有 minThreads <= maxThreads 的约束。逻辑与上面完全一致,只是方法名换成了 setMinThreads 和 setMaxThreads。

单位的大坑:

- Tomcat:

setKeepAliveTime允许你指定单位(如TimeUnit.SECONDS)。 - Jetty:

setIdleTimeout只要一个int,默认单位是毫秒。 - 代码细节: 如果你的配置中心配的是“60秒”,传给 Jetty 时必须

* 1000。源码中有一行config.getKeepAliveTime().intValue(),这里需结合业务配置确认单位是否匹配,通常建议在 Service 层做统一的时间单位转换。

2. 黑科技监控:反射破解 Jetty 的“私有领地”

对于监控,我们要解决的是可见性问题。

2.1 Tomcat:光明正大

Tomcat 用的是 JDK 标准 API,所以获取监控指标非常顺滑:

getActiveCount(): 正在干活的线程。getQueue().size(): 正在排队的请求。getCompletedTaskCount(): 历史总处理量。

2.2 Jetty:暴力反射

Jetty 的 QueuedThreadPool 设计比较封闭。它的任务队列定义是这样的:

private final BlockingQueue<Runnable> _jobs;它是 private 的,而且没有 getQueue() 这样的公开方法返回整个队列对象。虽然 Jetty 提供了 getQueueSize(),但如果我们想知道队列的剩余容量 (remainingCapacity) 或者拒绝策略,公开 API 就不够用了。

oneThread 的解决方案:

使用 Java 反射 (Reflection) 暴力读取。

// 对应文档 JettyWebThreadPoolService 中的 getBasicMetrics 方法

@SneakyThrows

public WebThreadPoolBaseMetrics getBasicMetrics() {

// 1. 强转为 Jetty 线程池

QueuedThreadPool jettyExecutor = (QueuedThreadPool) executor;

// 2. 【黑科技】利用反射工具,强行读取私有字段 "_jobs"

// 注意:这里的字段名 "_jobs" 是硬编码的,依赖于 Jetty 源码实现

BlockingQueue jobs = (BlockingQueue) ReflectUtil.getFieldValue(jettyExecutor, "_jobs");

// 3. 拿到队列对象后,就可以为所欲为了

int remainingCapacity = jobs.remainingCapacity(); // 还能塞多少请求

// ...

}风险提示:

这种做法虽然强大,但有一个缺点:对 Jetty 版本敏感。如果哪天 Jetty 升级,把 _jobs 改名为 _tasks,这段代码就会报错。但在解决生产痛点面前,这个收益通常是值得的(而且 Jetty 核心字段名很少变)。

2.3 指标对齐

为了让监控大盘统一,代码做了一层语义映射:

- 标准语义

activeCount<--> JettygetBusyThreads() - 标准语义

currentPoolSize<--> JettygetThreads()

这样运维人员在看 Grafana 面板时,不需要关心底层是哪个容器。

3. 最后一块拼图:谁来触发?

现在车造好了(动态调参逻辑),仪表盘也装好了(监控指标),还需要一个驾驶员。

这个驾驶员就是配置中心监听器(Nacos/Apollo Listener)。

虽然文档里没有详细展示监听器的代码,但完整的链路是这样的:

- Nacos 后台: 你修改了 YAML 配置

tomcat.threads.max = 500并发布。 - Spring Cloud: 接收到

RefreshEvent。 - oneThread 适配器: 监听到配置变更事件。

- 调用 Service:

webThreadPoolService.updateThreadPool(newConfig)。 - 落地: 执行上述的

if-else安全逻辑,Tomcat 底层参数瞬间变化。 - 结果: 新进来的 HTTP 请求立刻享受到 500 个线程的处理能力,排队瞬间消除。

全文总结

通过这三篇的深度解析,我们完整拆解了 SpringBoot Web 容器动态线程池的实现原理:

- 原理篇: 认清了 Web 容器线程池是流量入口的瓶颈,理解了 Tomcat(扩容优先)和 Jetty(队列优先)的底层差异。

- 架构篇: 学习了利用 Spring

@Conditional进行自动装配,以及适配器模式统一接口的设计智慧。 - 实战篇: 掌握了“先扩 Max 后扩 Core”的安全调参顺序,以及利用反射获取 Jetty 私有队列数据的黑科技。

Comments NOTHING