第16小节:用户查询优惠券之缓存击穿

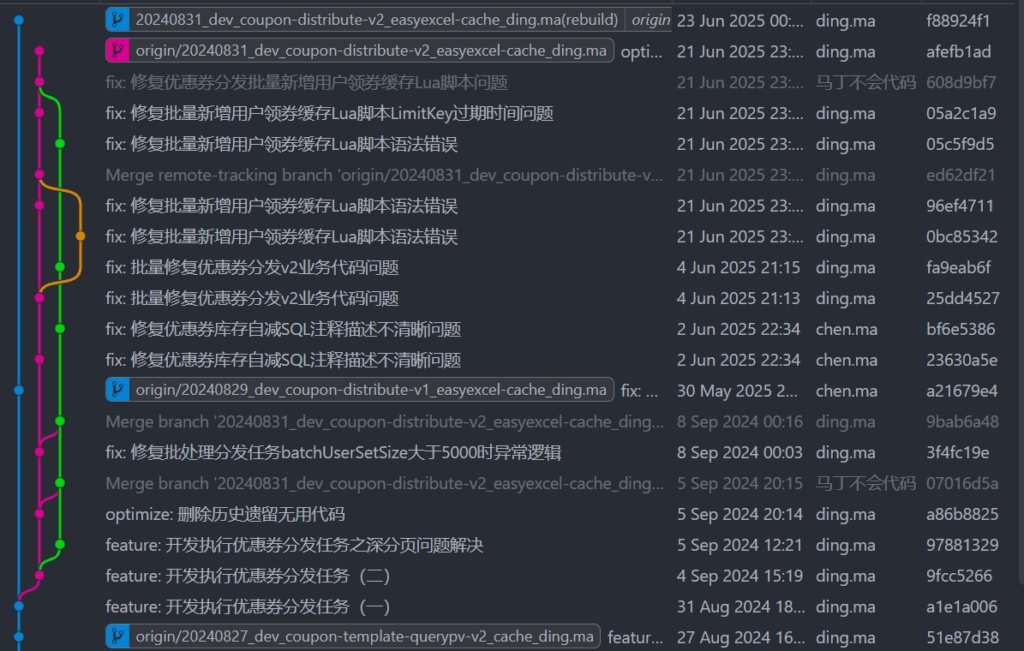

Git 分支

20240826_dev_coupon-template-query_cache_ding.ma

业务背景

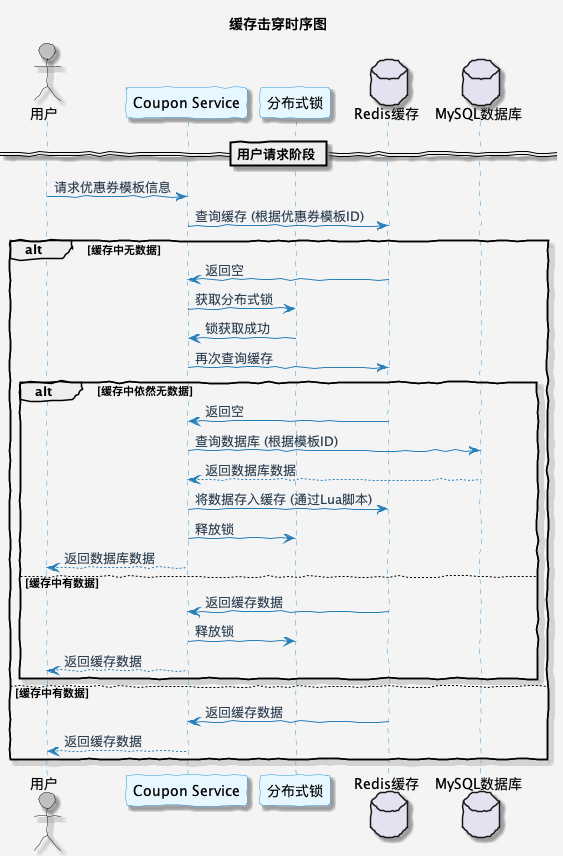

在分发服务中,我们需要调用优惠券模板的相关信息。为了避免各个服务中重复实现模板查询功能,我们首先编写了一个通用的引擎层模板查询方法,以支持 C 端用户和内部应用的查询。像这种大流量的接口,肯定是需要放到缓存的。

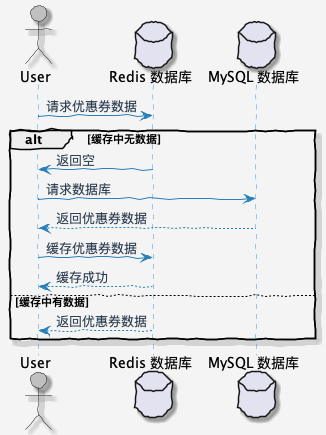

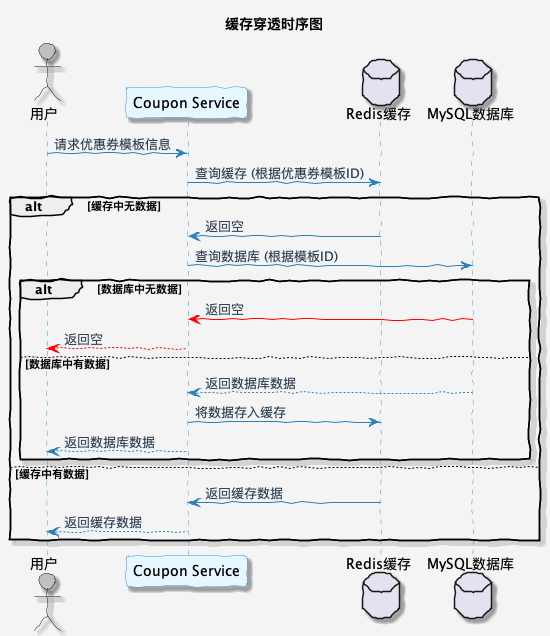

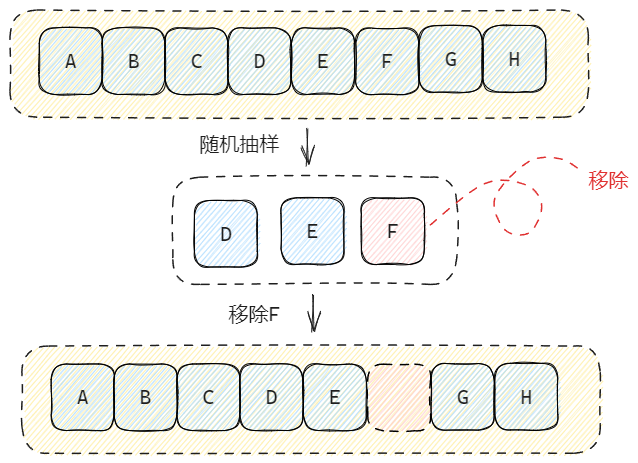

用户常规访问优惠券模板时序图如下:

什么是缓存击穿?

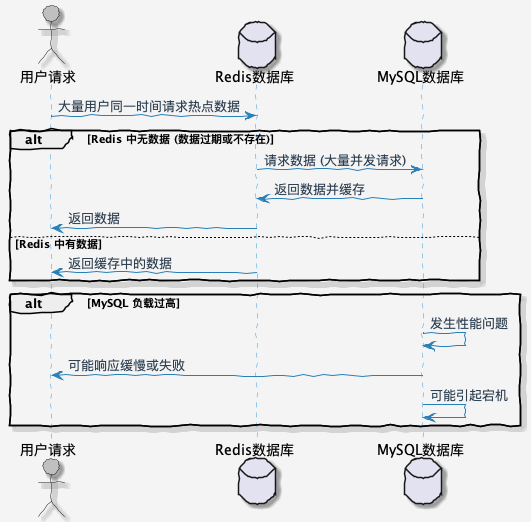

缓存击穿指在高并发的系统中,一个热点数据缓存过期或者在缓存中不存在,导致大量并发请求直接访问数据库,从而给数据库造成巨大压力,甚至可能引起宕机。

具体来说,当某个热点数据在缓存中过期时,如果此时有大量并发请求同时访问这个数据,由于缓存中不存在,所有请求都会直接访问数据库,导致数据库负载急剧增加。

伪代码如下所示:

public String selectTrain(String id) { String cacheData = cache.get(id); // 查询缓存不存在,去数据库查询并放入到缓存 if (StrUtil.isBlank(cacheData)) { // 获取数据库中存在的数据 String dbData = trainMapper.selectId(id); if (StrUtil.isNotBlank(dbData)) { // 将查询到的数据放入缓存,下次查询就有数据了 cahce.set(id, dbData); cacheData = dbData; } } return cacheData; }

缓存击穿解决方案

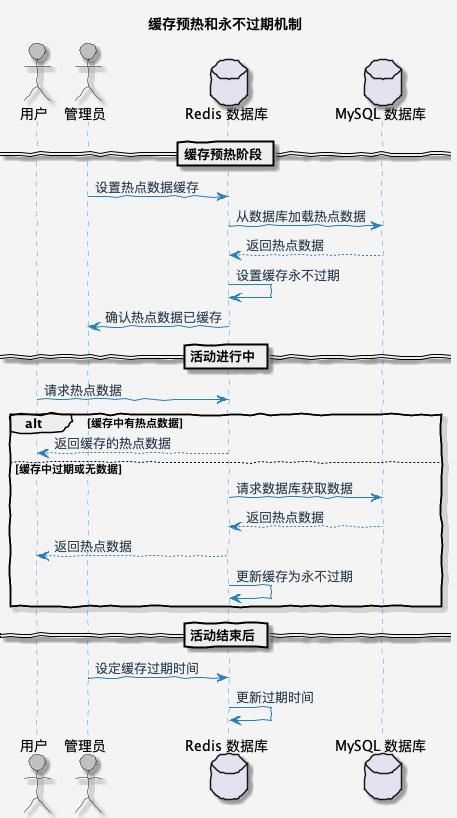

1. 预热和缓存永不过期

一般来说,我们会通过预热和缓存永不过期的机制让缓存不击穿,这样即使再大的流量也可以通过缓存去抗。

- 缓存预热:热点数据预加载,指的是在活动或者大促开始前,针对已知的热点数据从数据库加载到缓存中,这样可以避免海量请求第一次访问热点数据需要从数据库读取的流程。

- 永不过期:热点数据永不过期,指的就是可以预知的热点数据,在活动开始前,设置过期时间为 -1。这样的话,就不会有缓存击穿的风险。

上面两个一般都是搭配一起使用的。等对应热点缓存的活动结束后,这些数据访问量就比较低了,可以通过后台任务的方案对指定缓存设置过期时间,这样可以有效降低 Redis 存储压力。

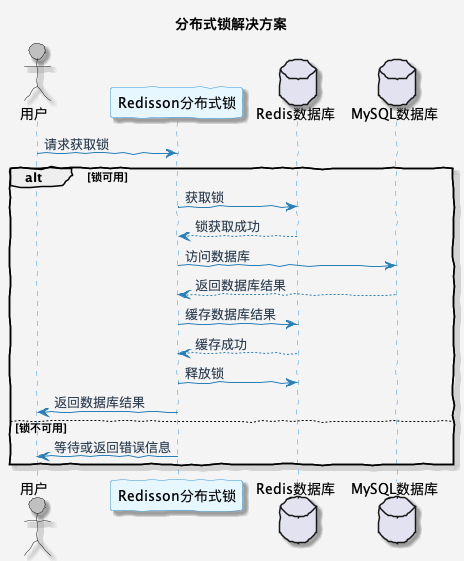

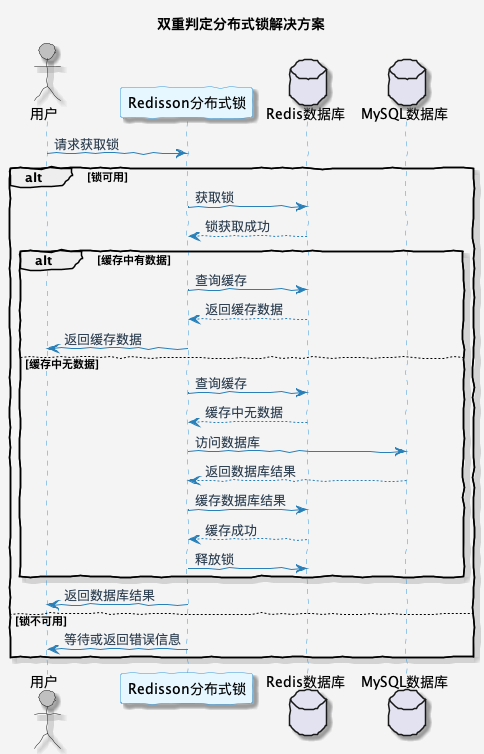

2. 分布式锁之双重判定锁

分布式锁的解决方案就是保证只有一个请求可以访问数据库,其它请求等待结果。这样可以避免大量的请求同时访问数据库。

在原有基础上继续改进,伪代码如下:

public String selectTrain(String id) {

String cacheData = cache.get(id); // 查询缓存

if (StrUtil.isBlank(cacheData)) { // 缓存不存在,去数据库查询并放入缓存

Lock lock = getLock(id); // 获取分布式锁

lock.lock();

try {

String dbData = trainMapper.selectId(id); // 查询数据库

if (StrUtil.isNotBlank(dbData)) { // 数据库中有数据

cache.set(id, dbData); // 将数据放入缓存

cacheData = dbData;

}

} finally {

lock.unlock(); // 释放锁

}

}

return cacheData;

}但是这种的话有一个弊端,那就是获取分布式锁的请求,都会执行一遍查询数据库,并更新到缓存。理论上只有第一个加载数据库记录请求是有效的。

针对这个问题,可以通过双重判定锁的形式,在获取到分布式锁之后,再次查询一次缓存是否存在。如果缓存中存在数据,就直接返回;如果不存在,才继续执行查询数据库的操作。这样就可以避免大量请求访问数据库。

伪代码如下:

public String selectTrain(String id) {

// 查询缓存

String cacheData = cache.get(id);

// 查询缓存不存在,去数据库查询并放入到缓存

if (StrUtil.isBlank(cacheData)) {

// 为避免大量请求同时访问数据库,通过分布式锁减少数据库访问量

Lock lock = getLock(id);

lock.lock();

try {

// 获取锁后双重判定

cacheData = cache.get(id);

// 理论上只有第一个请求加载数据库是有效的,因为它加载后会把数据放到缓存

// 后面的请求再请求数据库加载缓存就没有必要了

if (StrUtil.isBlank(cacheData)) {

// 获取数据库中存在的数据

String dbData = trainMapper.selectId(id);

if (StrUtil.isNotBlank(dbData)) {

// 将查询到的数据放入缓存,下次查询就有数据了

cache.set(id, dbData);

cacheData = dbData;

}

}

} finally {

lock.unlock();

}

}

return cacheData;

}下面是这种场景下解决方案的一般步骤:

- 1. 获取锁:在查询数据库前,首先尝试获取一个分布式锁。只有一个线程能够成功获取锁,其他线程需要等待;

- 2. 查询数据库:如果双重判断确认数据确实不存在于缓存中,那么就执行查询数据库的操作,获取数据;

- 3. 写入缓存:获取到数据后,将数据写入缓存,并设置一个合适的过期时间,以防止缓存永远不会被更新;

- 4. 释放锁:最后,释放获取的锁,以便其他线程可以继续使用这个锁。

3. 高并发极端情况

很多同学认为到这里就结束了,但这恰恰只是开始,真正难得是接下来要讲的。

我举个场景,有一万个请求同一时间访问触发了缓存击穿,如果用双重判定锁,逻辑是这样的:

- 1. 第一个请求加锁、查询缓存是否存在、查询数据库、放入缓存、解锁,假设我们用了50毫秒;

- 2. 第二个请求拿到锁查询缓存、解锁用了1毫秒;

- 3. 那最后一个请求需要等待10049毫秒后才能返回,用户等待时间过长,极端情况下可能会触发应用的内存溢出。

3.1 尝试获取锁 tryLock

像上面这种场景,类似于秒杀的架构,我们要做的就是不让用户请求在服务端阻塞过长时间。那就可以使用尝试获取锁 tryLock API,它的语义是如果拿锁失败直接返回,而不是阻塞等待直到获取锁。

public String selectTrain(String id) {

// 查询缓存不存在,去数据库查询并放入到缓存

String cacheData = cache.get(id);

if (StrUtil.isBlank(cacheData)) {

// 为避免大量请求同时访问数据库,通过分布式锁减少数据库访问量

Lock lock = getLock(id);

// 尝试获取锁,获取失败直接返回用户请求,并提醒用户稍后再试

if (!lock.tryLock()) {

throw new RuntimeException("当前访问人数过多,请稍候再试...");

}

try {

// 获取数据库中存在的数据

String dbData = trainMapper.selectId(id);

if (StrUtil.isNotBlank(dbData)) {

// 将查询到的数据放入缓存,下次查询就有数据了

cache.set(id, dbData);

cacheData = dbData;

}

} finally {

lock.unlock();

}

}

return cacheData;

}通过这种方式我们可以快速失败,告诉用户网络异常请稍后再试,等用户再尝试刷新的时候,其实获取锁的线程已经把数据放到了缓存。

因为这种方案对用户操作体验不友好,所以也只是适用于部分场景。在实际开发中,需要灵活变更。

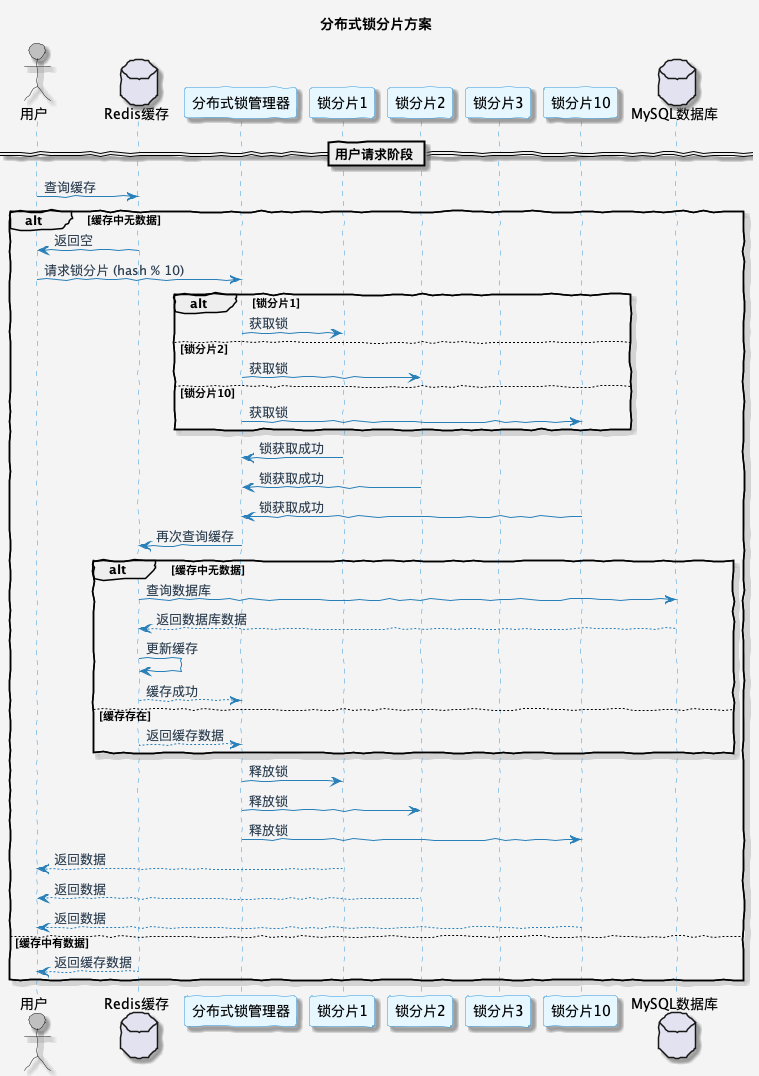

3.2 分布式锁分片

还有一种比较优雅的解决方案是通过分布式锁分片的形式,让并行的线程更多一些。因为同一时间有多个线程能同时操作,所以理论上,设置分片量的多少,也就是性能提升了近多少倍。

伪代码如下所示:

public String selectTrain(String id, String userId) {

// 查询缓存不存在,去数据库查询并放入到缓存

String cacheData = cache.get(id);

if (StrUtil.isBlank(cacheData)) {

// 假设设置10把分布式锁,那么就通过唯一标识(这里取用户ID)进行取模获取分片下标

int idx = Math.abs(userId.hashCode()) % 10;

// 为避免大量请求同时访问数据库,通过分布式锁减少数据库访问量

Lock lock = getLock(id + idx);

lock.lock();

try {

// 获取锁后双重判定

cacheData = cache.get(id);

// 理论上只有第一个请求加载数据库是有效的,因为它加载后会把数据放到缓存

// 后面的请求再请求数据库加载缓存就没有必要了

if (StrUtil.isBlank(cacheData)) {

// 获取数据库中存在的数据

String dbData = trainMapper.selectId(id);

if (StrUtil.isNotBlank(dbData)) {

// 将查询到的数据放入缓存,下次查询就有数据了

cache.set(id, dbData);

cacheData = dbData;

}

}

} finally {

lock.unlock();

}

}

return cacheData;

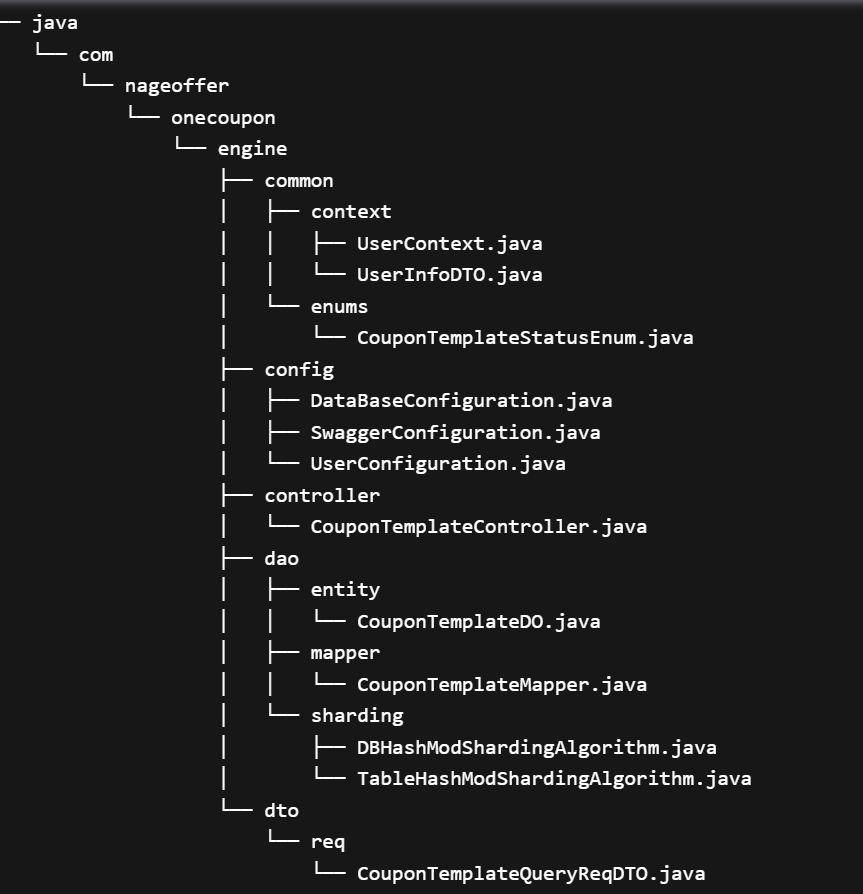

}开发优惠券模板查询

1. 常规优惠券模板查询

第一版本的代码是最为原始的直接查询数据库,数据量大的时候,肯定是没办法扛住的,所以我们接下来引入解决了缓存击穿的版本。

package com.nageoffer.onecoupon.engine.service.impl;

import cn.hutool.core.bean.BeanUtil;

import com.baomidou.mybatisplus.core.conditions.query.LambdaQueryWrapper;

import com.baomidou.mybatisplus.core.toolkit.Wrappers;

import com.baomidou.mybatisplus.extension.service.impl.ServiceImpl;

import com.nageoffer.onecoupon.engine.common.enums.CouponTemplateStatusEnum;

import com.nageoffer.onecoupon.engine.dao.entity.CouponTemplateDO;

import com.nageoffer.onecoupon.engine.dao.mapper.CouponTemplateMapper;

import com.nageoffer.onecoupon.engine.dto.req.CouponTemplateQueryReqDTO;

import com.nageoffer.onecoupon.engine.dto.resp.CouponTemplateQueryRespDTO;

import com.nageoffer.onecoupon.engine.service.CouponTemplateService;

import lombok.RequiredArgsConstructor;

import lombok.extern.slf4j.Slf4j;

import org.springframework.stereotype.Service;

/**

* 优惠券模板业务逻辑实现层

* <p>

* 作者:马丁

* 加项目群:早加入就是优势!500人内部项目群,分享的知识总有你需要的 <a href="https://t.zsxq.com/cw7b9 " />

* 开发时间:2024-07-08

*/

@Slf4j

@Service

@RequiredArgsConstructor

public class CouponTemplateServiceImpl extends ServiceImpl<CouponTemplateMapper, CouponTemplateDO> implements CouponTemplateService {

private final CouponTemplateMapper couponTemplateMapper;

@Override

public CouponTemplateQueryRespDTO findCouponTemplate(CouponTemplateQueryReqDTO requestParam) {

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

return BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

}

}2. 查询优惠券模板缓存

我们省去了简单的分布式过程,上面已经有简单的示例,直接用较常见的双重判定锁。

@Override

public CouponTemplateQueryRespDTO findCouponTemplate(CouponTemplateQueryReqDTO requestParam) {

// 查询 Redis 缓存中是否存在优惠券模板信息

String couponTemplateCacheKey = String.format(EngineRedisConstant.COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId());

Map couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

// 如果存在直接返回,不存在需要通过双重判定锁的形式读取数据库中的记录

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

// 获取优惠券模板分布式锁

// 关于缓存击穿更多注释事项,欢迎查看我的B站视频:https://www.bilibili.com/video/BV1qz421z7vC

RLock lock = redissonClient.getLock(String.format(EngineRedisConstant.LOCK_COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId()));

lock.lock();

try {

// 通过双重判定锁优化大量请求无意义查询数据库

couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

// 优惠券模板不存在或者已过期直接抛出异常

if (couponTemplateDO == null) {

throw new ClientException("优惠券模板不存在或已过期");

}

// 通过将数据库的记录序列化成 JSON 字符串放入 Redis 缓存

CouponTemplateQueryRespDTO actualRespDTO = BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

Map<String, Object> cacheTargetMap = BeanUtil.beanToMap(actualRespDTO, false, true);

Map<String, String> actualCacheTargetMap = cacheTargetMap.entrySet().stream()

.collect(Collectors.toMap(

Map.Entry::getKey,

entry -> entry.getValue() != null ? entry.getValue().toString() : ""

));

// 通过 LUA 脚本执行设置 Hash 数据以及设置过期时间

String luaScript = "redis.call('HMSET', KEYS[1], unpack(ARGV, 1, #ARGV - 1)) " +

"redis.call('EXPIREAT', KEYS[1], ARGV[#ARGV])";

List<String> keys = Collections.singletonList(couponTemplateCacheKey);

List<String> args = new ArrayList<>(actualCacheTargetMap.size() * 2 + 1);

actualCacheTargetMap.forEach((key, value) -> {

args.add(key);

args.add(value);

});

// 优惠券活动过期时间转换为秒级别的 Unix 时间戳

args.add(String.valueOf(couponTemplateDO.getValidEndTime().getTime() / 1000));

// 执行 LUA 脚本

stringRedisTemplate.execute(

new DefaultRedisScript<>(luaScript, Long.class),

keys,

args.toArray()

);

couponTemplateCacheMap = cacheTargetMap.entrySet()

.stream()

.collect(Collectors.toMap(Map.Entry::getKey, Map.Entry::getValue));

}

} finally {

lock.unlock();

}

}

return BeanUtil.mapToBean(couponTemplateCacheMap, CouponTemplateQueryRespDTO.class, false, CopyOptions.create());}

看了上面缓存击穿理论知识后,这个代码就比较容易理解。其中因为我们要进行准换 Hash putAll 方法所以需要进行多次 Map 转换,这个属于是业务复杂性导致,如果只是简单放个 String 代码流程会简单很多。

优惠券模板缓存击穿查询时序图如下所示:

文末总结

虽然我们讲了多种缓存击穿的方案,其中说到的 tryLock 和分布式锁分片一般只会出现在面试中,因为国内 99.99% 的公司不存在存在高并发极端的情况,写个双重判定锁已经是对业务的尊重了。可以背八股,但别被八股带进去。

优惠券模板有有效期开始时间、结束时间两个字段,所以把缓存的过期时间设置成和优惠券模板有效期的结束时间一致,查不到缓存就直接提示用户优惠券模板已经失效,是不是就能不用考虑缓存击穿问题了

我想可能有些场景下某个优惠券只能在有效期时间内的指定时间使用,所以考虑到这点就没用你说的方法?

如果Redis的内存超出最大内存,仍有效优惠券模板 存在被淘汰的风险

缓存中的优惠券模板记录过期时间在创建的时候就已经设置了 为了预防redis特定热点key失效(不一定是到达过期时间) 导致缓存击穿问题 所以才需要考虑

@Slf4j

@Service

@RequiredArgsConstructor

public class CouponTemplateServiceImpl extends ServiceImpl<CouponTemplateMapper, CouponTemplateDO> implements CouponTemplateService {

private final CouponTemplateMapper couponTemplateMapper;

private final StringRedisTemplate stringRedisTemplate;

private final RedissonClient redissonClient;

@Override

public CouponTemplateQueryRespDTO findCouponTemplate(CouponTemplateQueryReqDTO requestParam) {

// 查询 Redis 缓存中是否存在优惠券模板信息

String couponTemplateCacheKey = String.format(EngineRedisConstant.COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId());

Map<Object, Object> couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

// 如果存在直接返回,不存在需要通过双重判定锁的形式读取数据库中的记录

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

// 获取优惠券模板分布式锁

// 关于缓存击穿更多注释事项,欢迎查看我的B站视频:https://www.bilibili.com/video/BV1qz421z7vC

RLock lock = redissonClient.getLock(String.format(EngineRedisConstant.LOCK_COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId()));

lock.lock();

try {

// 通过双重判定锁优化大量请求无意义查询数据库

couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

// 优惠券模板不存在或者已过期直接抛出异常

if (couponTemplateDO == null) {

throw new ClientException("优惠券模板不存在或已过期");

}

// 通过将数据库的记录序列化成 JSON 字符串放入 Redis 缓存

CouponTemplateQueryRespDTO actualRespDTO = BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

Map<String, Object> cacheTargetMap = BeanUtil.beanToMap(actualRespDTO, false, true);

Map<String, String> actualCacheTargetMap = cacheTargetMap.entrySet().stream()

.collect(Collectors.toMap(

Map.Entry::getKey,

entry -> entry.getValue() != null ? entry.getValue().toString() : ""

));

// 通过 LUA 脚本执行设置 Hash 数据以及设置过期时间

String luaScript = "redis.call('HMSET', KEYS[1], unpack(ARGV, 1, #ARGV - 1)) " +

"redis.call('EXPIREAT', KEYS[1], ARGV[#ARGV])";

List<String> keys = Collections.singletonList(couponTemplateCacheKey);

List<String> args = new ArrayList<>(actualCacheTargetMap.size() * 2 + 1);

actualCacheTargetMap.forEach((key, value) -> {

args.add(key);

args.add(value);

});

// 优惠券活动过期时间转换为秒级别的 Unix 时间戳

args.add(String.valueOf(couponTemplateDO.getValidEndTime().getTime() / 1000));

// 执行 LUA 脚本

stringRedisTemplate.execute(

new DefaultRedisScript<>(luaScript, Long.class),

keys,

args.toArray()

);

couponTemplateCacheMap = cacheTargetMap.entrySet()

.stream()

.collect(Collectors.toMap(Map.Entry::getKey, Map.Entry::getValue));

}

} finally {

lock.unlock();

}

}

return BeanUtil.mapToBean(couponTemplateCacheMap, CouponTemplateQueryRespDTO.class, false, CopyOptions.create());

}

}

public final class EngineRedisConstant {

/**

* 优惠券模板缓存 Key

*/

public static final String COUPON_TEMPLATE_KEY = "one-coupon_engine:template:%s";

/**

* 优惠券模板缓存分布式锁 Key

*/

public static final String LOCK_COUPON_TEMPLATE_KEY = "one-coupon_engine:lock:template:%s";

}

第17小节:用户查询优惠券之缓存穿透

业务背景

在上一节中,我们讨论了正常用户在访问优惠券时可能遇到的缓存击穿问题,并介绍了缓存预热、缓存永不过期、分布式锁、双重判定锁、分片分布式锁等技术来应对这些问题。然而,还有一个问题需要解决:如果用户频繁访问数据库中不存在的数据,就无法有效使用缓存,每次都需要访问数据库,这将导致数据库承受较大的压力。这也就是缓存穿透问题。

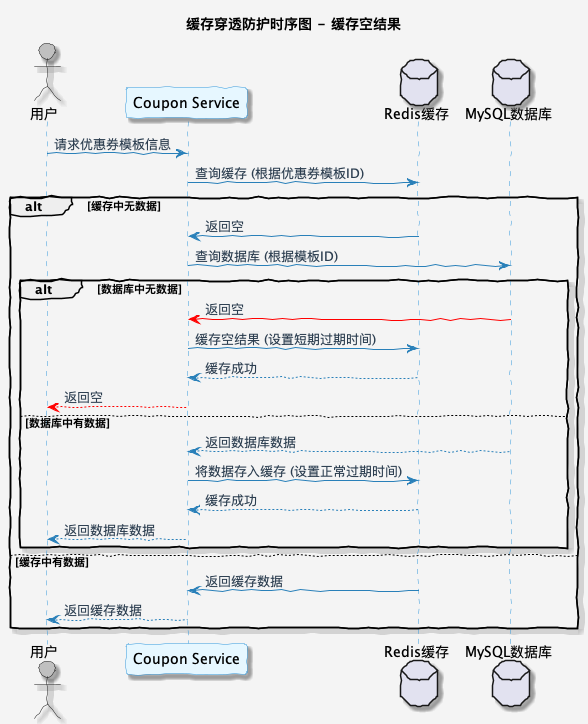

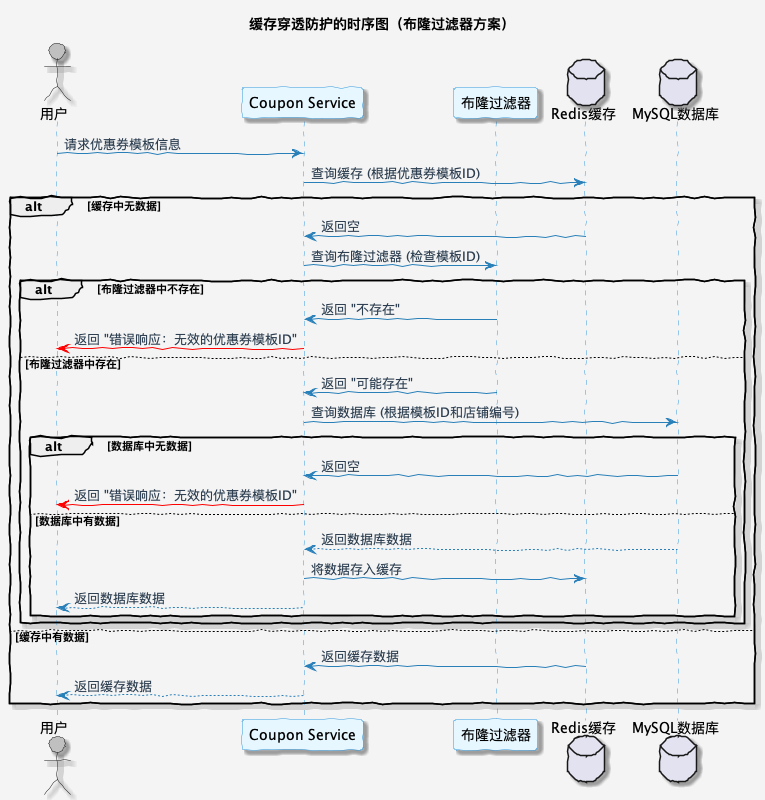

缓存穿透问题时序图如下所示:

Git 分支

20240827_dev_coupon-template-querypv-v2_cache_ding.ma

什么是缓存穿透?

缓存穿透是指由于请求没有办法命中缓存,因此就会直接打到数据库,当请求量较大时,大量的请求就可能会直接把数据库打挂。

通常情况下,缓存是为了提高数据访问速度,避免频繁查询数据库。但如果攻击者故意请求缓存中不存在的数据,就会导致缓存不命中,请求直接访问数据库。

没有经过缓存穿透处理的业务伪代码如下:

public String selectUser(String userId) {

String cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

String dbData = userMapper.selectId(userId);

if (StrUtil.isNotBlank(dbData)) {

cahce.set(userId, dbData);

cacheData = dbData;

} else {

throw new RuntimeException();

}

}

return cacheData;

}缓存穿透常见解决方案

1. 空对象缓存

当查询结果为空时,也将结果进行缓存,但是设置一个较短的过期时间。这样在接下来的一段时间内,如果再次请求相同的数据,就可以直接从缓存中获取,而不是再次访问数据库,可以一定程度上解决缓存穿透问题。

缓存空值逻辑伪代码实现如下:

public String selectUser(String userId) {

String cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

// 判断 Key 是否包含空值缓存,存在直接返回,不存在继续流程

Boolean cacheIsNull = cache.hasKey("is-null_" + userId);

if (cacheIsNull) {

throw new RuntimeException();

}

String dbData = userMapper.selectId(userId);

if (StrUtil.isNotBlank(dbData)) {

cahce.set(userId, dbData);

cacheData = dbData;

} else {

// 查询数据库中不存在数据,添加空值缓存并返回

cache.set("is-null_" + userId, 较短过期时间);

throw new RuntimeException();

}

}

return cacheData;

}这种方式是比较简单的一种实现方案,会存在一些弊端。那就是当短时间内存在大量恶意请求,缓存系统会存在大量的内存占用。

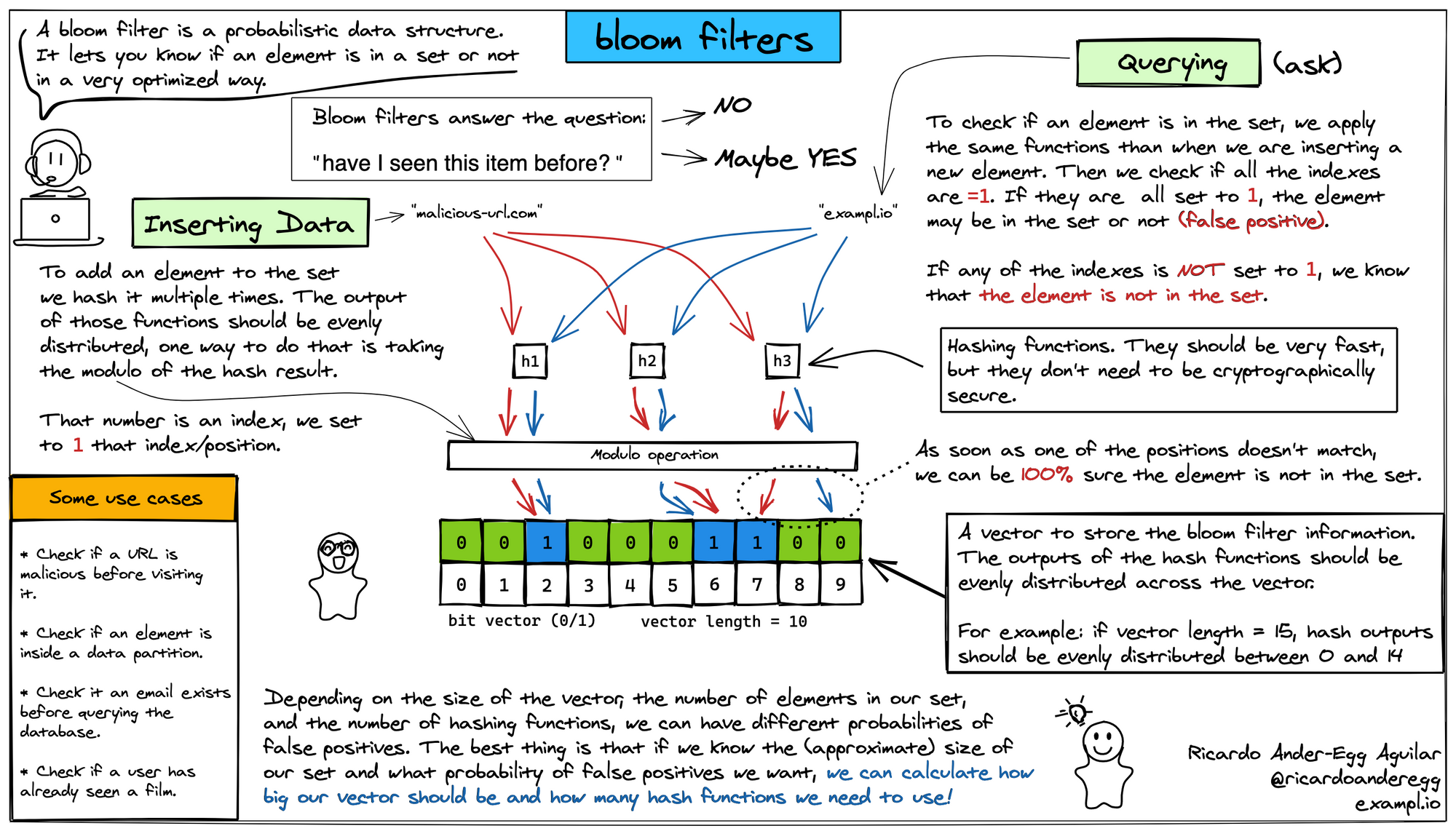

2. 布隆过滤器

2.1 什么是布隆过滤器

布隆过滤器是一种数据结构,用于快速判断一个元素是否存在于一个集合中。它以牺牲一定的准确性为代价,换取了存储空间的极大节省和查询速度的显著提升。

具体来说,布隆过滤器包含一个位数组和一组哈希函数。位数组的初始值全部置为 0。在插入一个元素时,将该元素经过多个哈希函数映射到位数组上的多个位置,并将这些位置的值置为 1。

因为每个元素存储都是以位来存储,而不是字节,所以元素的占用空间非常小。

1 字节(Byte)= 8 位(Bit)在计算机科学中,数据存储的最小单位是位(Bit),而字节(Byte)则是一个常用的数据存储单位,通常由8个位组成。

在查询一个元素是否存在时,会将该元素经过多个哈希函数映射到位数组上的多个位置,如果所有位置的值都为 1,则认为元素存在;如果存在任一位置的值为 0,则认为元素不存在。

2.2 布隆过滤器优缺点

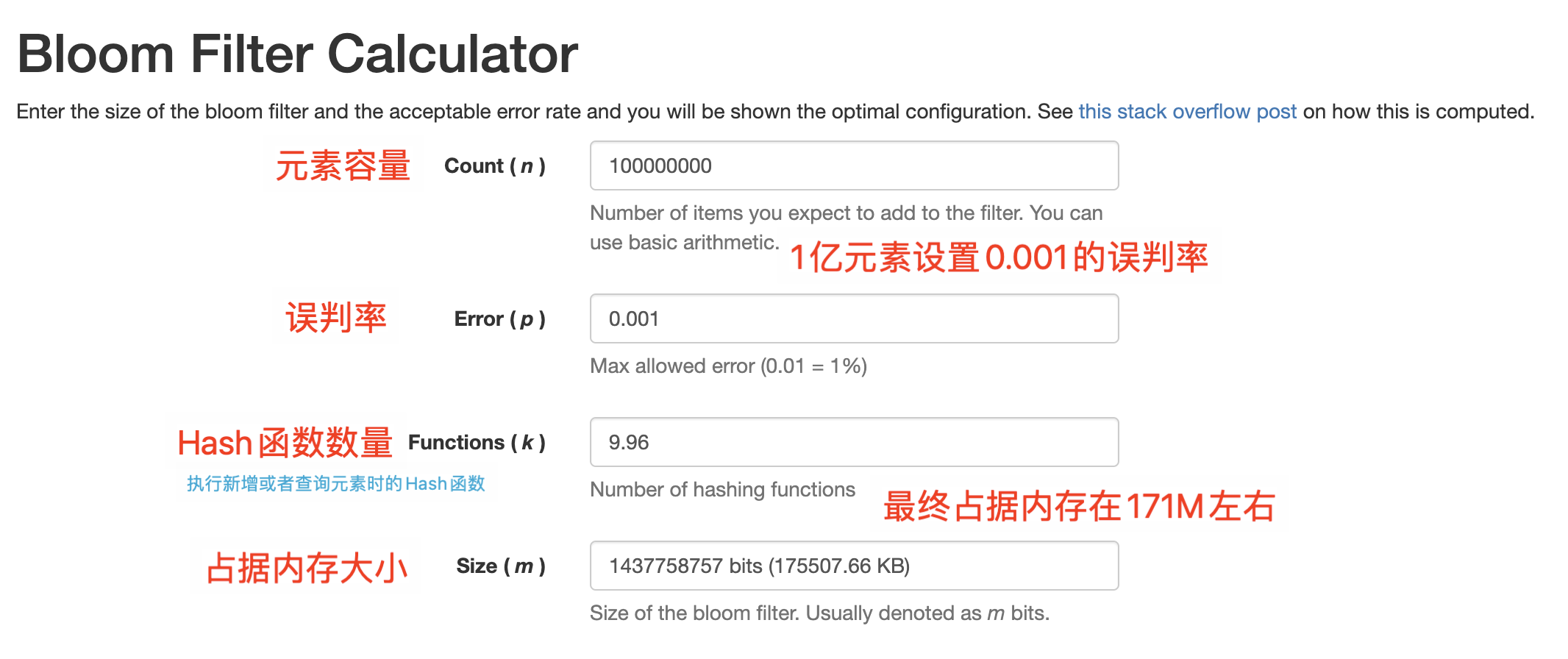

布隆过滤器的优点在于它可以高效地判断一个元素是否属于一个大规模集合,且具有极低的存储空间要求。如果存储 1亿元素,误判率设置为 0.001 也就是千分之一,仅需要占用 171M 左右的内存。

缺点在于可能会存在一定的误判率。

它在实际应用中常用于缓存场景下缓存穿透问题,对访问请求做一个快速判断机制。使用布隆过滤器能够有效减轻对底层存储系统的访问以及缓存系统的存储压力。

但是布隆过滤器本身也存在一些“弊端”,那就是不支持删除元素。因为它是一种基于哈希的数据结构,删除元素会涉及到多个哈希函数之间的冲突问题,这样会导致删除一个元素可能会影响到其他元素的正确性。

总的来说,布隆过滤器是一种非常高效的数据结构,适用于那些可以容忍一定的误判率的场合。

2.3 布隆过滤器解决缓存穿透

可以将所有存量数据全部放入布隆过滤器,然后如果缓存中不存在数据,紧接着判断布隆过滤器是否存在,如果存在访问数据库请求数据,如果不存在直接返回错误响应即可。

使用布隆过滤器解决缓存穿透伪代码如下:

public String selectUser(String userId) {

String cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

if (!bloomFilter.contains(fullShortUrl)) {

throw new RuntimeException();

}

String dbData = userMapper.selectId(userId);

if (StrUtil.isNotBlank(dbData)) {

cahce.set(userId, dbData);

cacheData = dbData;

}

}

return cacheData;

}但是这种问题还是会有一些小概率问题,那就是如果使用一种小概率误判的缓存进行攻击,依然会对数据库造成比较大的压力。这个怎么理解呢?

- 1. 比如说一个优惠券 ID 是 1827975299049058306,我通过优惠券 ID 规则,模拟一个不存在的但很相近的,比如 1827975299049058307,去碰撞那个误判的概率;

- 2. 怎么判断这个数据是不是存在?就是看接口的响应时间,直接查询缓存和布隆过滤器是绝对的毫秒级,比如 5 毫秒,而且性能基本上比较恒定。那我们就可以根据相应时间是否大于 5 毫秒,因为误判了还会查一次数据库;

- 3. 如果查询第一次大于 5 毫秒且数据返回为空,那就证明这是个碰撞漏网之鱼,直接拿高并发访问即可,还是会请求到数据库。

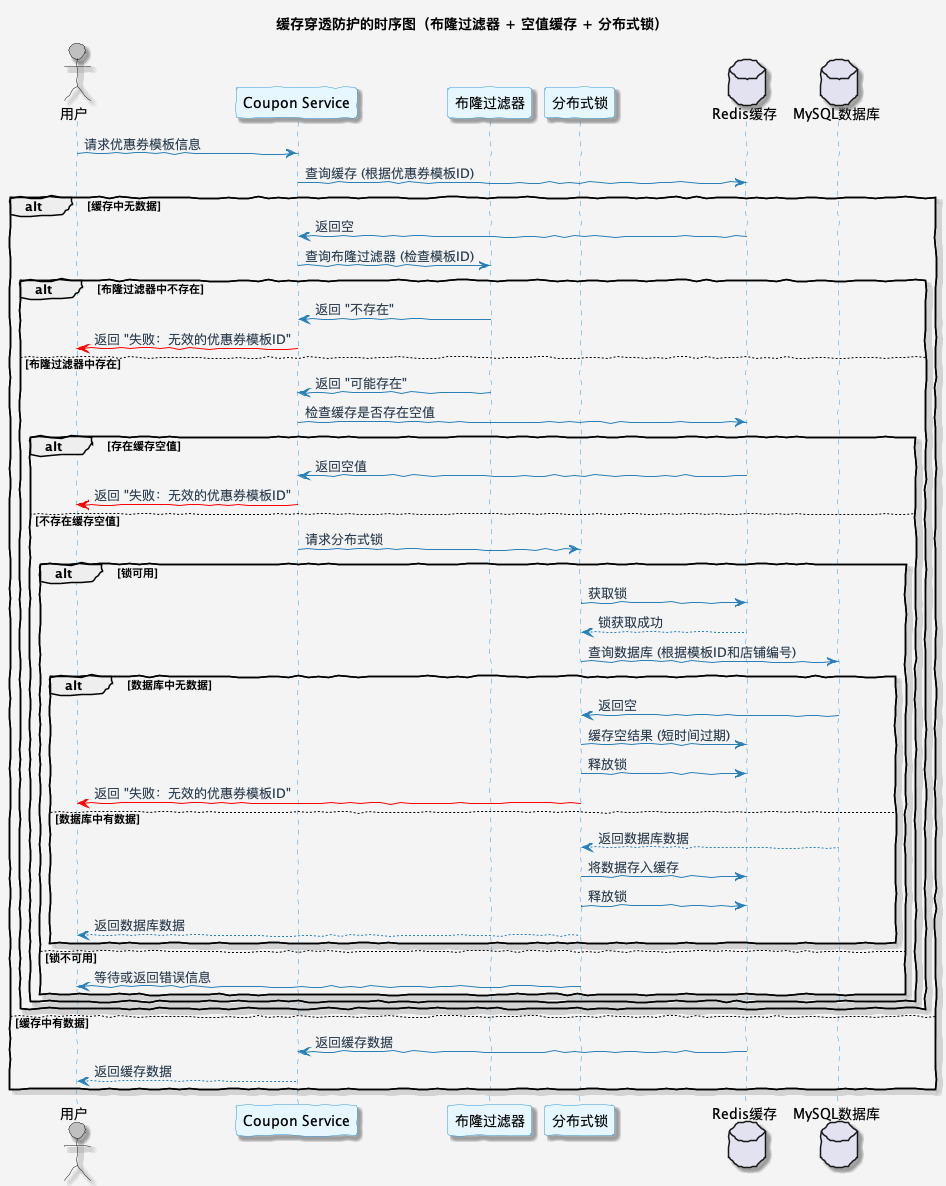

3. 布隆过滤器+空值缓存+分布式锁

如果说缓存不存在,那么就通过布隆过滤器进行初步筛选,然后判断是否存在缓存空值,如果存在直接返回失败。如果不存在缓存空值,使用锁机制避免多个相同请求同时访问数据库。最后,如果请求数据库为空,那么将为空的 Key 进行空对象值缓存。

多重方案伪代码如下所示:

public String selectUser(String userId) {

String cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

// 判断 Key 是否存在布隆过滤器,存在则继续流程,否则直接返回

if (!bloomFilter.contains(fullShortUrl)) {

throw new RuntimeException();

}

// 判断 Key 是否包含空值缓存,存在直接返回,不存在继续流程

Boolean cacheIsNull = cache.hasKey("is-null_" + userId);

if (cacheIsNull) {

throw new RuntimeException();

}

// 获取分布式锁

Lock lock = getLock(userId);

lock.lock();

try {

// 拿到锁之后进行双重判定,如果缓存已经存在则直接返回即可

cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

String dbData = userMapper.selectId(userId);

if (StrUtil.isNotBlank(dbData)) {

cahce.set(userId, dbData);

cacheData = dbData;

} else {

// 查询数据库中不存在数据,添加空值缓存并返回

cache.set("is-null_" + userId, 较短过期时间);

throw new RuntimeException();

}

}

} finally {

lock.unlock();

}

}

return cacheData;

}之前我考虑到这就结束了,得益于我开源的 SaaS 短链接项目,有很多细心的同学给我提了一些建议。那就是在获取到锁后,不止对正常缓存双重判定,同时也要对空值缓存对象做双重判定。

public String selectUser(String userId) {

String cacheData = cache.get(userId);

if (StrUtil.isBlank(cacheData)) {

// 判断 Key 是否存在布隆过滤器,存在则继续流程,否则直接返回

if (!bloomFilter.contains(fullShortUrl)) {

throw new RuntimeException();

}

// 判断 Key 是否包含空值缓存,存在直接返回,不存在继续流程

Boolean cacheIsNull = cache.hasKey("is-null_" + userId);

if (cacheIsNull) {

throw new RuntimeException();

}

// 获取分布式锁

Lock lock = getLock(userId);

lock.lock();

try {

// 拿到锁之后进行双重判定,如果缓存已经存在则直接返回即可

cacheData = cache.get(userId);

if (StrUtil.isNotBlank(cacheData)) {

return cacheData;

}

// 拿到锁之后进行双重判定,如果空值缓存已经存在则直接终止流程即可

cacheIsNull = cache.hasKey("is-null_" + userId);

if (!cacheIsNull) {

throw new RuntimeException();

}

// 根据用户标识查询数据库记录

String dbData = userMapper.selectId(userId);

if (StrUtil.isNotBlank(dbData)) {

cahce.set(userId, dbData);

cacheData = dbData;

} else {

// 查询数据库中不存在数据,添加空值缓存并返回

cache.set("is-null_" + userId, 较短过期时间);

throw new RuntimeException();

}

} finally {

lock.unlock();

}

}

return cacheData;

}至此,缓存穿透解决方案完美结束。

上面写得缓存穿透代码思路,只要不出现极端场景,大概率能涵盖 90% 工作当中的业务场景。

优惠券模板引入缓存穿透解决方案

1. 创建布隆过滤器

下面这个配置需要在优惠券后管和引擎模块都需要添加,以后管中配置代码举例:

@Configuration

public class RBloomFilterConfiguration {

/**

* 优惠券查询缓存穿透布隆过滤器

*/

@Bean

public RBloomFilter<String> couponTemplateQueryBloomFilter(RedissonClient redissonClient) {

RBloomFilter<String> bloomFilter = redissonClient.getBloomFilter("couponTemplateQueryBloomFilter");

bloomFilter.tryInit(640L, 0.001);

return bloomFilter;

}

}

其中 tryInit 有两个参数,代表预估插入量和错误概率,因为会根据这两个参数进行初始化布隆过滤器的位数组,不建议大家设置太大。

2.1 预计插入量 expectedInsertions

这是一个估计值,表示布隆过滤器预期将会插入的元素总数。

通过知道预期的插入量,布隆过滤器可以根据这个估计值来合理地配置位数组的大小和哈希函数的数量。这样可以在达到指定错误率的情况下,最大限度地节省内存。插入的元素数量如果超出预期,会增加误判的概率。

2.2 错误概率 falseProbability

表示布隆过滤器在给定条件下可能返回错误结果的概率。

错误概率用于在布隆过滤器初始化时确定其位数组的大小和哈希函数的数量。较低的误判率意味着需要更大的位数组和更多的哈希函数,从而占用更多的内存和计算时间。反之,较高的误判率则意味着更少的内存占用和计算成本,但错误判定的概率也会增加。

2. 创建优惠券模板添加布隆过滤器

我们创建优惠券模板方法里,需要将优惠券模板 ID 存一份到布隆过滤器中,代码如下:

@Slf4j

@Service

@RequiredArgsConstructor

public class CouponTemplateServiceImpl extends ServiceImpl<CouponTemplateMapper, CouponTemplateDO> implements CouponTemplateService {

// ......

private final RBloomFilter<String> couponTemplateQueryBloomFilter;

@Override

public void createCouponTemplate(CouponTemplateSaveReqDTO requestParam) {

// ......

// 添加优惠券模板 ID 到布隆过滤器

couponTemplateQueryBloomFilter.add(String.valueOf(couponTemplateDO.getId()));

}

}3. 改造优惠券模板查询缓存穿透

我们先写一个单独的缓存穿透解决方案,后面再和击穿逻辑结合一起。

查询优惠券模板请求第一步,判断布隆过滤器是否存在指定模板 ID,不存在直接返回错误。

@Slf4j

@Service

@RequiredArgsConstructor

public class CouponTemplateServiceImpl extends ServiceImpl<CouponTemplateMapper, CouponTemplateDO> implements CouponTemplateService {

private final RBloomFilter<String> couponTemplateQueryBloomFilter;

@Override

public CouponTemplateQueryRespDTO findCouponTemplate(CouponTemplateQueryReqDTO requestParam) {

if (!couponTemplateQueryBloomFilter.contains(requestParam.getCouponTemplateId())) {

throw new ClientException("优惠券模板不存在");

}

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

return BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

}

}4. 改造组合方案

我们在这个方法里,引入缓存布隆过滤器、空值以及分布式锁逻辑,应用到我们的优惠券模板查询解决方案中。

代码看着挺多,但是都是按照我们上面讲的布隆过滤器、控制缓存、分布式锁逻辑一步步来的。

@Slf4j

@Service

@RequiredArgsConstructor

public class CouponTemplateServiceImpl extends ServiceImpl<CouponTemplateMapper, CouponTemplateDO> implements CouponTemplateService {

private final CouponTemplateMapper couponTemplateMapper;

private final StringRedisTemplate stringRedisTemplate;

private final RedissonClient redissonClient;

private final RBloomFilter<String> couponTemplateQueryBloomFilter;

@Override

public CouponTemplateQueryRespDTO findCouponTemplate(CouponTemplateQueryReqDTO requestParam) {

// 查询 Redis 缓存中是否存在优惠券模板信息

String couponTemplateCacheKey = String.format(EngineRedisConstant.COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId());

Map<Object, Object> couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

// 如果存在直接返回,不存在需要通过布隆过滤器、缓存空值以及双重判定锁的形式读取数据库中的记录

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

// 判断布隆过滤器是否存在指定模板 ID,不存在直接返回错误

if (!couponTemplateQueryBloomFilter.contains(requestParam.getCouponTemplateId())) {

throw new ClientException("优惠券模板不存在");

}

// 查询 Redis 缓存中是否存在优惠券模板空值信息,如果有代表模板不存在,直接返回

String couponTemplateIsNullCacheKey = String.format(EngineRedisConstant.COUPON_TEMPLATE_IS_NULL_KEY, requestParam.getCouponTemplateId());

Boolean hasKeyFlag = stringRedisTemplate.hasKey(couponTemplateIsNullCacheKey);

if (hasKeyFlag) {

throw new ClientException("优惠券模板不存在");

}

// 获取优惠券模板分布式锁

// 关于缓存击穿更多注释事项,欢迎查看我的B站视频:https://www.bilibili.com/video/BV1qz421z7vC

RLock lock = redissonClient.getLock(String.format(EngineRedisConstant.LOCK_COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId()));

lock.lock();

try {

// 双重判定空值缓存是否存在,存在则继续抛异常

hasKeyFlag = stringRedisTemplate.hasKey(couponTemplateIsNullCacheKey);

if (hasKeyFlag) {

throw new ClientException("优惠券模板不存在");

}

// 通过双重判定锁优化大量请求无意义查询数据库

couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

// 优惠券模板不存在或者已过期加入空值缓存,并且抛出异常

if (couponTemplateDO == null) {

stringRedisTemplate.opsForValue().set(couponTemplateIsNullCacheKey, "", 30, TimeUnit.MINUTES);

throw new ClientException("优惠券模板不存在或已过期");

}

// 通过将数据库的记录序列化成 JSON 字符串放入 Redis 缓存

CouponTemplateQueryRespDTO actualRespDTO = BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

Map<String, Object> cacheTargetMap = BeanUtil.beanToMap(actualRespDTO, false, true);

Map<String, String> actualCacheTargetMap = cacheTargetMap.entrySet().stream()

.collect(Collectors.toMap(

Map.Entry::getKey,

entry -> entry.getValue() != null ? entry.getValue().toString() : ""

));

// 通过 LUA 脚本执行设置 Hash 数据以及设置过期时间

String luaScript = "redis.call('HMSET', KEYS[1], unpack(ARGV, 1, #ARGV - 1)) " +

"redis.call('EXPIREAT', KEYS[1], ARGV[#ARGV])";

List<String> keys = Collections.singletonList(couponTemplateCacheKey);

List<String> args = new ArrayList<>(actualCacheTargetMap.size() * 2 + 1);

actualCacheTargetMap.forEach((key, value) -> {

args.add(key);

args.add(value);

});

// 优惠券活动过期时间转换为秒级别的 Unix 时间戳

args.add(String.valueOf(couponTemplateDO.getValidEndTime().getTime() / 1000));

// 执行 LUA 脚本

stringRedisTemplate.execute(

new DefaultRedisScript<>(luaScript, Long.class),

keys,

args.toArray()

);

couponTemplateCacheMap = cacheTargetMap.entrySet()

.stream()

.collect(Collectors.toMap(Map.Entry::getKey, Map.Entry::getValue));

}

} finally {

lock.unlock();

}

}

return BeanUtil.mapToBean(couponTemplateCacheMap, CouponTemplateQueryRespDTO.class, false, CopyOptions.create());

}

/**

* 缓存击穿解决方案

*/

public CouponTemplateQueryRespDTO findCouponTemplateV1(CouponTemplateQueryReqDTO requestParam) {

// 查询 Redis 缓存中是否存在优惠券模板信息

String couponTemplateCacheKey = String.format(EngineRedisConstant.COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId());

Map<Object, Object> couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

// 如果存在直接返回,不存在需要通过双重判定锁的形式读取数据库中的记录

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

// 获取优惠券模板分布式锁

// 关于缓存击穿更多注释事项,欢迎查看我的B站视频:https://www.bilibili.com/video/BV1qz421z7vC

RLock lock = redissonClient.getLock(String.format(EngineRedisConstant.LOCK_COUPON_TEMPLATE_KEY, requestParam.getCouponTemplateId()));

lock.lock();

try {

// 通过双重判定锁优化大量请求无意义查询数据库

couponTemplateCacheMap = stringRedisTemplate.opsForHash().entries(couponTemplateCacheKey);

if (MapUtil.isEmpty(couponTemplateCacheMap)) {

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

// 优惠券模板不存在或者已过期直接抛出异常

if (couponTemplateDO == null) {

throw new ClientException("优惠券模板不存在或已过期");

}

// 通过将数据库的记录序列化成 JSON 字符串放入 Redis 缓存

CouponTemplateQueryRespDTO actualRespDTO = BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

Map<String, Object> cacheTargetMap = BeanUtil.beanToMap(actualRespDTO, false, true);

Map<String, String> actualCacheTargetMap = cacheTargetMap.entrySet().stream()

.collect(Collectors.toMap(

Map.Entry::getKey,

entry -> entry.getValue() != null ? entry.getValue().toString() : ""

));

// 通过 LUA 脚本执行设置 Hash 数据以及设置过期时间

String luaScript = "redis.call('HMSET', KEYS[1], unpack(ARGV, 1, #ARGV - 1)) " +

"redis.call('EXPIREAT', KEYS[1], ARGV[#ARGV])";

List<String> keys = Collections.singletonList(couponTemplateCacheKey);

List<String> args = new ArrayList<>(actualCacheTargetMap.size() * 2 + 1);

actualCacheTargetMap.forEach((key, value) -> {

args.add(key);

args.add(value);

});

// 优惠券活动过期时间转换为秒级别的 Unix 时间戳

args.add(String.valueOf(couponTemplateDO.getValidEndTime().getTime() / 1000));

// 执行 LUA 脚本

stringRedisTemplate.execute(

new DefaultRedisScript<>(luaScript, Long.class),

keys,

args.toArray()

);

couponTemplateCacheMap = cacheTargetMap.entrySet()

.stream()

.collect(Collectors.toMap(Map.Entry::getKey, Map.Entry::getValue));

}

} finally {

lock.unlock();

}

}

return BeanUtil.mapToBean(couponTemplateCacheMap, CouponTemplateQueryRespDTO.class, false, CopyOptions.create());

}

/**

* 缓存穿透解决方案之布隆过滤器

*/

public CouponTemplateQueryRespDTO findCouponTemplateV2(CouponTemplateQueryReqDTO requestParam) {

// 判断布隆过滤器是否存在指定模板 ID,不存在直接返回错误

if (!couponTemplateQueryBloomFilter.contains(requestParam.getCouponTemplateId())) {

throw new ClientException("优惠券模板不存在");

}

LambdaQueryWrapper<CouponTemplateDO> queryWrapper = Wrappers.lambdaQuery(CouponTemplateDO.class)

.eq(CouponTemplateDO::getShopNumber, Long.parseLong(requestParam.getShopNumber()))

.eq(CouponTemplateDO::getId, Long.parseLong(requestParam.getCouponTemplateId()))

.eq(CouponTemplateDO::getStatus, CouponTemplateStatusEnum.ACTIVE.getStatus());

CouponTemplateDO couponTemplateDO = couponTemplateMapper.selectOne(queryWrapper);

return BeanUtil.toBean(couponTemplateDO, CouponTemplateQueryRespDTO.class);

}

}

如果我们按照正常逻辑,是没有办法触发缓存空值等操作的。所以需要在正常逻辑下,加一些人工破坏,流程如下:

- 1. 确保商家后管系统已经接入了布隆过滤器流程,通过商家后管系统添加新的优惠券;

- 2. 去数据库把刚才那一条记录删除或者 status 设置为 1 也就是已结束状态。

通过这种方式,大家就能触发类似于布隆过滤器误判,然后触发缓存空值和分布式锁等流程。

常见问题答疑

1. 布隆过滤器设置多大容量?

布隆过滤器的容量就取决于业务的数量,我们之前在分库分表的章节上说,可能有 300 亿的优惠券模板数量,是不是直接设置为布隆过滤器的容量就好了?

不行的,你可以尝试下设置 300 亿预估元素以及千分之一的误判率,绝对会报错。因为

Bloom filter size can't be greater than 4294967294. But calculated size is 431327626981

简单梳理了下,意思是:布隆过滤器大小不能超过 4294967294,但是咱们的参数 300 亿预估值和 千分之一的误判率,已经超过了这个数据。

如果设置 300 亿数据预估值但是设置百分之一的误判率,那么报错就换了一个。可以看到布隆过滤器给我们设置了上限,不能超过。

Bloom filter size can't be greater than 4294967294. But calculated size is 287551751321

小知识点,一个亿的元素,如果千分之一的误判率,那么实际容量大概在 170M 左右。另外在对布隆过滤器进行初始化的时候,会一次性申请对应的内存,这个需要额外注意下,避免初始化超大容量布隆过滤器时内存不足问题。

那这种情况下如何解决布隆过滤器不能设置 300 亿数据问题?

可以像之前在处理缓存击穿时所用的分片逻辑一样,设置多个布隆过滤器,使得这些分片的布隆过滤器总容量能达到 300 亿。然后根据模板 ID 进行分片,确定要操作的布隆过滤器,从而在该分片上进行操作。

2. 分布式锁 lock 会触发长时间阻塞么?

这个逻辑和缓存击穿里的逻辑是一样的,大家可以参考缓存击穿章节中的 tryLock 和分布式锁分片处理方案。

第18小节:如何设置Redis内存淘汰策略?

业务背景

在之前讨论缓存击穿的问题时,有一个关键点没有详细介绍,那就是如何与 Redis 的内存淘汰策略结合使用。仅仅依靠缓存预热和设置数据永不过期并不是一个全面的解决方案,还需要考虑合适的内存淘汰策略来保障缓存击穿方案有效执行。

什么是内存淘汰?

内存总是有限的,因此当 Redis 内存超出最大内存时,就需要根据一定的策略去主动的淘汰一些 Key,来腾出内存,这就是内存淘汰策略。我们可以在配置文件中通过 maxmemory-policy 配置指定策略。

与到期删除策略不同,内存淘汰策略主要目的则是为了防止运行时内存超过最大内存,所以尽管最终目的都是清理内存中的一些 Key,但是它们的应用场景和触发时机是不同的。

算上在 4.0 添加的两种基于 LFU 算法的策略, Redis 一共提供了八种策略供我们选择:

noeviction,不淘汰任何 key,直接报错。它是默认策略。volatile-random:从所有设置了到期时间的 Key 中,随机淘汰一个 Key。volatile-lru: 从所有设置了到期时间的 Key 中,淘汰最近最少使用的 Key。volatile-lfu: 从所有设置了到期时间的 Key 中,淘汰最近最不常用使用的 Key(4.0 新增)。volatile-ttl: 从所有设置了到期时间的 Key 中,优先淘汰最早过期的 Key。allkeys-random:从所有 Key 中,随机淘汰一个键。allkeys-lru: 从所有 Key 中,淘汰最近最少使用的 Key。allkeys-lfu: 从所有 Key 中,淘汰最近最不常用使用的键(4.0 新增)。

从淘汰范围来说可以分为不淘汰任何数据、只从设置了到期时间的键中淘汰和从所有键中淘汰三类。而从淘汰算法来分,又主要分为 Random(随机),LRU(最近最少使用),以及 LFU(最近最不常使用)三种。

其中,关于 LRU 算法,它是一种非常常见的缓存淘汰算法。我们可以简单理解为 Redis 会在每次访问 Key 的时候记录访问时间,当淘汰时,优先淘汰最后一次访问距离现在最早的 Key。

而对于 LFU 算法,我们可以理解为 Redis 会在访问 Key 时,根据两次访问时间的间隔计算并累加访问频率指标,当淘汰时,优先淘汰访问频率指标最低的 key。相比 LRU 算法,它避免了低频率的大批量查询造成的缓存污染问题。

什么是缓存污染问题?

LRU 有个最大问题,就是它只认最近一次访问时间。而如果出现系统偶尔需要一次性读取大量数据的时候,会大规模更新 Key 的最近访问时间,从而导致真正需要被频繁访问的 Key 因为最近一次访问时间更早而被直接淘汰。这种情况被称为缓存污染。为此,我们需要使用 LFU 算法来解决。

淘汰策略对缓存击穿的影响?

举个例子,我们操作了缓存预热和设置 Redis 永不过期,如果说设置 Redis 内存淘汰策略是以下类型:

allkeys-random:从所有 Key 中,随机淘汰一个键。allkeys-lru: 从所有 Key 中,淘汰最近最少使用的 Key。allkeys-lfu: 从所有 Key 中,淘汰最近最不常用使用的键(4.0 新增)。

因为是从所有键中去执行淘汰算法,是否有可能将咱们设置的热 Key 或者说访问较多的 Key 给淘汰掉?第一种绝对有可能,第二三种虽然概率比较小,但是也不是没可能。

所以,我们只能从这几个淘汰算法中进行选择:

noeviction,不淘汰任何 Key,直接报错。volatile-random:从所有设置了到期时间的 Key 中,随机淘汰一个 Key。volatile-lru: 从所有设置了到期时间的 Key 中,淘汰最近最少使用的 Key。volatile-lfu: 从所有设置了到期时间的 Key 中,淘汰最近最不常用使用的 Key(4.0 新增)。volatile-ttl: 从所有设置了到期时间的 Key 中,优先淘汰最早过期的 Key。

牛券选择哪个淘汰策略?

从常规上来说,如果大家公司 Redis 比较豪,也就是业务挣钱,在资源上不吝啬,必然毫不犹豫选择 noeviction 不淘汰任何任何数据。

简单的来说,如果你的业务数据的访问比较平均,不存在明显的冷热区别,那么 LRU 可以满足一般的使用需求。如果你的业务具备很强的时效性,而且是存在大促商品这种明显的热点数据,那么推荐你使用 LFU。

因为牛券里的一些模板也不全是常用的,适当内存吃紧的时候可以淘汰一部分带过期时间的 Key,再加上牛券中的优惠券存在明显的冷热数据现象,我建议使用 volatile-lfu,可以有效避免 LRU 的缓存污染问题。

以下内容了解即可,如不容易理解,可跳过知道如何应用即可。

内存淘汰底层原理

1. 淘汰过程

Redis 内存淘汰执行流程如下:

- 1. 每次当 Redis 执行命令时,若设置了最大内存大小

maxmemory,并设置了淘汰策略式,则会尝试进行一次 Key 淘汰; - 2. Redis 首先会评估已使用内存(这里不包含主从复制使用的两个缓冲区占用的内存)是否大于

maxmemory,如果没有则直接返回,否则将计算当前需要释放多少内存,随后开始根据策略淘汰符合条件的 Key;当开始进行淘汰时,将会依次对每个数据库进行抽样,抽样的数据范围由策略决定,而样本数量则由maxmemory-samples配置决定; - 3. 完成抽样后,Redis 会尝试将样本放入提前初始化好

EvictionPoolLRU数组中,它相当于一个临时缓冲区,当数组填满以后即将里面全部的 Key 进行删除。 - 4. 若一次删除后内存仍然不足,则再次重复上一步骤,将样本中的剩余 Key 再次填入数组中进行删除,直到释放了足够的内存,或者本次抽样的所有 Key 都被删除完毕(如果此时内存还是不足,那么就重新执行一次淘汰流程)。

在抽样这一步,涉及到从字典中随机抽样这个过程,由于哈希表的 Key 是散列分布的,因此会有很多桶都是空的,纯随机效率可能会很低。因此,Redis 采用了一个特别的做法,那就是先连续遍历数个桶,如果都是空的,再随机调到另一个位置,再连续遍历几个桶……如此循环,直到结束抽样。

你可以参照源码理解这个过程:

unsigned int dictGetSomeKeys(dict *d, dictEntry **des, unsigned int count) {

unsigned long j; /* internal hash table id, 0 or 1. */

unsigned long tables; /* 1 or 2 tables? */

unsigned long stored = 0, maxsizemask;

unsigned long maxsteps;

if (dictSize(d) < count) count = dictSize(d);

maxsteps = count*10;

// 如果字典正在迁移,则协助迁移

for (j = 0; j < count; j++) {

if (dictIsRehashing(d))

_dictRehashStep(d);

else

break;

}

tables = dictIsRehashing(d) ? 2 : 1;

maxsizemask = d->ht[0].sizemask;

if (tables > 1 && maxsizemask < d->ht[1].sizemask)

maxsizemask = d->ht[1].sizemask;

unsigned long i = random() & maxsizemask;

unsigned long emptylen = 0;

// 当已经采集到足够的样本,或者重试已达上限则结束采样

while(stored < count && maxsteps--) {

for (j = 0; j < tables; j++) {

if (tables == 2 && j == 0 && i < (unsigned long) d->rehashidx) {

if (i >= d->ht[1].size)

i = d->rehashidx;

else

continue;

}

// 如果一个库的到期字典已经处理完毕,则处理下一个库

if (i >= d->ht[j].size) continue;

dictEntry *he = d->ht[j].table[i];

// 连续遍历多个桶,如果多个桶都是空的,那么随机跳到另一个位置,然后再重复此步骤

if (he == NULL) {

emptylen++;

if (emptylen >= 5 && emptylen > count) {

i = random() & maxsizemask;

emptylen = 0;

}

} else {

emptylen = 0;

while (he) {

*des = he;

des++;

he = he->next;

stored++;

if (stored == count) return stored;

}

}

}

// 查找下一个桶

i = (i+1) & maxsizemask;

}

return stored;

}2. LRU 实现

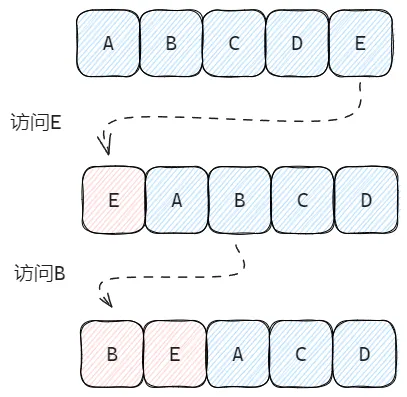

LRU 的全称为 Least Recently Used,也就是最近最少使用。一般来说,LRU 会从一批 Key 中淘汰上次访问时间最早的 key。

它是一种非常常见的缓存回收算法,在诸如 Guava Cache、Caffeine等缓存库中都提供了类似的实现。我们自己也可以基于 JDK 的 LinkedHashMap 实现支持 LRU 算法的缓存功能。

2.1 近似 LRU

传统的 LRU 算法实现通常会维护一个链表,当访问过某个节点后就将该节点移至链表头部。如此反复后,链表的节点就会按最近一次访问时间排序。当缓存数量到达上限后,我们直接移除尾节点,即可移除最近最少访问的缓存。

不过,对于 Redis 来说,如果每个 Key 添加的时候都需要额外的维护并操作这样一条链表,要额外付出的代价显然是不可接受的,因此 Redis 中的 LRU 是近似 LRU(NearlyLRU)。

当每次访问 Key 时,Redis 会在结构体中记录本次访问时间,而当需要淘汰 Key 时,将会从全部数据中进行抽样,然后再移除样本中上次访问时间最早的 key。

它的特点是:

- 仅当需要时再抽样,因而不需要维护全量数据组成的链表,这避免了额外内存消耗。

- 访问时仅在结构体上记录操作时间,而不需要操作链表节点,这避免了额外的性能消耗。

当然,有利就有弊,这种实现方式也决定 Redis 的 LRU 是并不是百分百准确的,被淘汰的 Key 未必真的就是所有 Key 中最后一次访问时间最早的。

2.2 抽样大小

根据上述的内容,我们不难理解,当抽样的数量越大,LRU 淘汰 Key 就越准确,相对的开销也更大。因此,Redis 允许我们通过 maxmemory-samples 配置采样数量(默认为 5),从而在性能和精度上取得平衡。

3. LFU 实现

LFU 全称为 Least Frequently Used ,也就是最近最不常用。它的特点如下:

- 同样是基于抽样实现的近似算法,

maxmemory-samples对其同样有效。 - 比较的不是最后一次访问时间,而是数据的访问频率。当淘汰的时候,优先淘汰范围频率最低 Key。

它的实现与 LRU 基本一致,但是在计数部分则有所改进。

3.1 概率计数器

在 Redis 用来存储数据的结构体 redisObj 中,有一个 24 位的 lru数值字段:

- 当使用 LRU 算法时,它用于记录最后一次访问时间的时间戳。

- 当使用 LFU 算法时,它被分为两部分,高 16 位关于记录最近一次访问时间(

Last Decrement Time),而低 8 位作为记录访问频率计数器(Logistic Counter)。

LFU 的核心就在于低 8 位表示的访问频率计数器(下面我们简称为 counter),是一个介于 0 ~ 255 的特殊数值,它会每次访问 Key 时,基于时间衰减和概率递增机制动态改变。

这种基于概率,使用极小内存对大量事件进行计数的计数器被称为莫里斯计数器,它是一种概率计数法的实现。

3.2 时间衰减

每当访问 Key 时,根据当前实际与该 Key 的最后一次访问时间的时间差对 counter 进行衰减。

衰减值取决于 lfu_decay_time 配置,该配置表示一个衰减周期。我们可以简单的认为,每当时间间隔满足一个衰减周期时,就会对 counter 减一。

比如,我们设置 lfu_decay_time为 1 分钟,那么如果 Key 最后一次访问距离现在已有 3 分 30 秒,那么 counter 就需要减 3。

3.3 概率递增

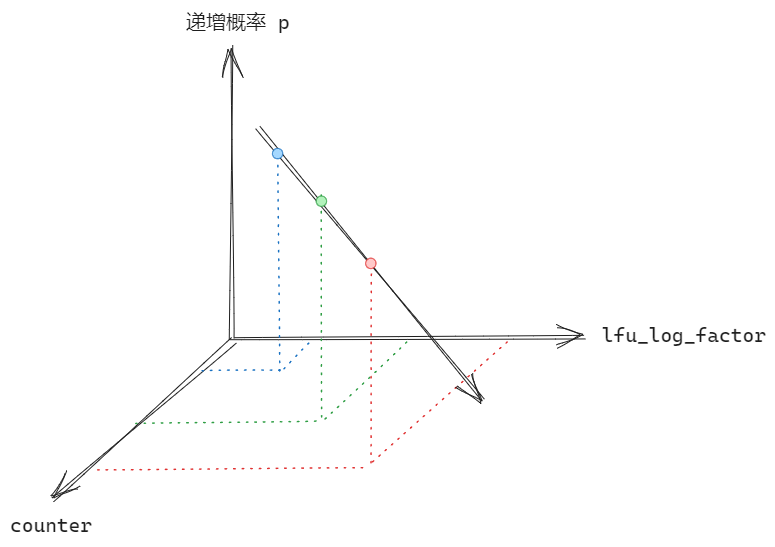

在完成衰减后,Redis 将根据 lfu_log_factor 配置对应概率值对 counter 进行递增。

这里直接放上源码:

/* Logarithmically increment a counter. The greater is the current counter value * the less likely is that it gets really implemented. Saturate it at 255. */ uint8_t LFULogIncr(uint8_t counter) { // 若已达最大值 255,直接返回 if (counter == 255) return 255; // 获取一个介于 0 到 1 之间的随机值 double r = (double)rand()/RAND_MAX; // 根据当前 counter 减去初始值得到 baseval double baseval = counter - LFU_INIT_VAL; if (baseval < 0) baseval = 0; // 使用 baseval*server.lfu_log_factor+1 得到一个概率值 p double p = 1.0/(baseval*server.lfu_log_factor+1); // 当 r < p 时,递增 counter if (r < p) counter++; return counter; }

简而言之,直接从代码上理解,我们可以认为 counter和 lfu_log_factor 越大,则递增的概率越小:

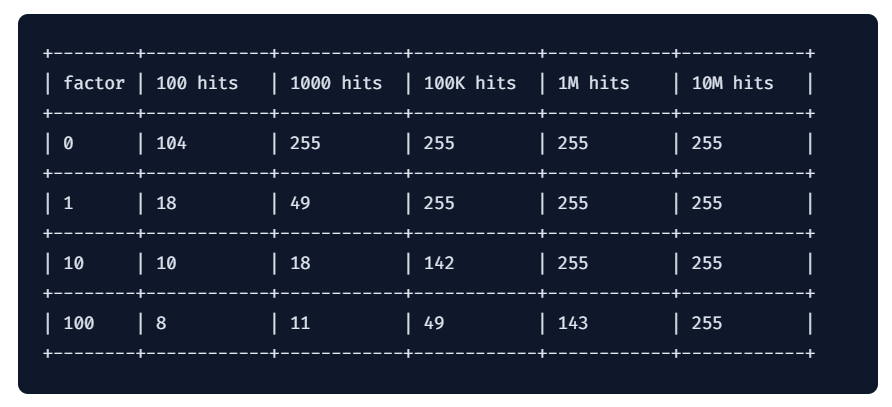

当然,实际上也要考虑到访问次数对其的影响,Redis 官方给出了相关数据:

具体可直接参见:vivo LRU与LFU算法实现 sourl.cn/4yZ6e2

3.4 计数器的初始值

为了防止新的 Key 由于 counter 为 0 导致直接被淘汰,Redis 会默认将 counter设置为 5。

3.5 抽样大小的选择

值得注意的是,当数据量比较大的时候,如果抽样大小设置的过小,因为一次抽样的样本数量有限,冷热数据因为时间衰减导致的权重差异将会变得不明显,此时 LFU 算法的优势就难以体现,即使的相对较热的数据也有可能被频繁“误伤”。

所以,如果你选择了 LFU 算法作为淘汰策略,并且同时又具备比较大的数据量,那么不妨将抽样大小也设置的大一些。

完结,撒花 🎉

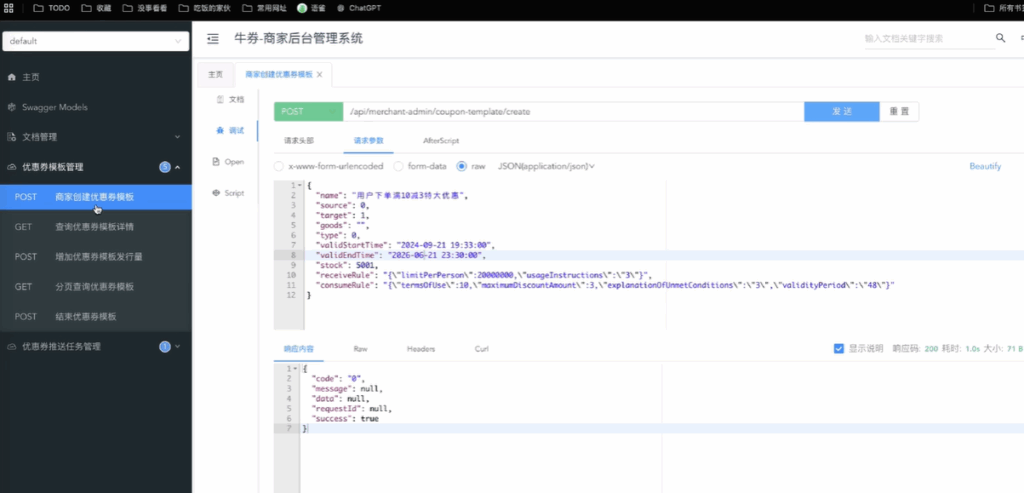

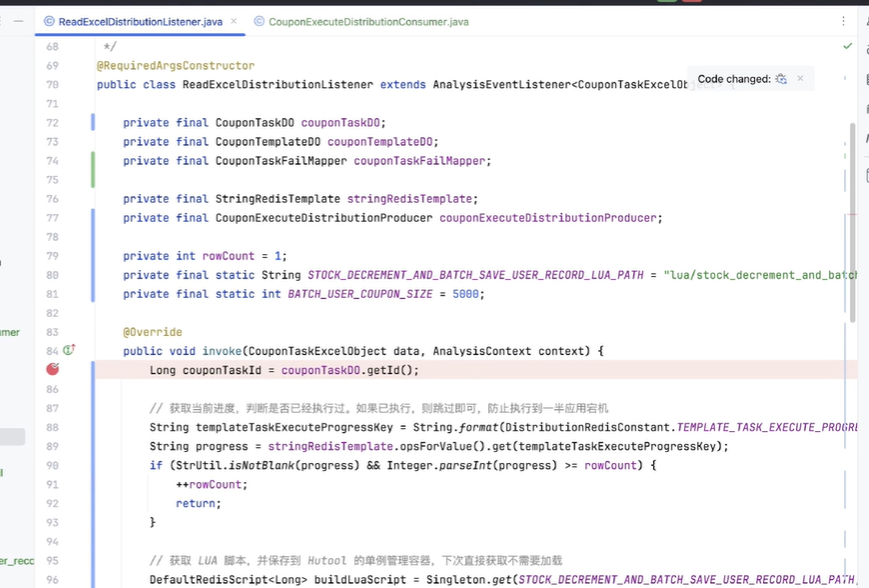

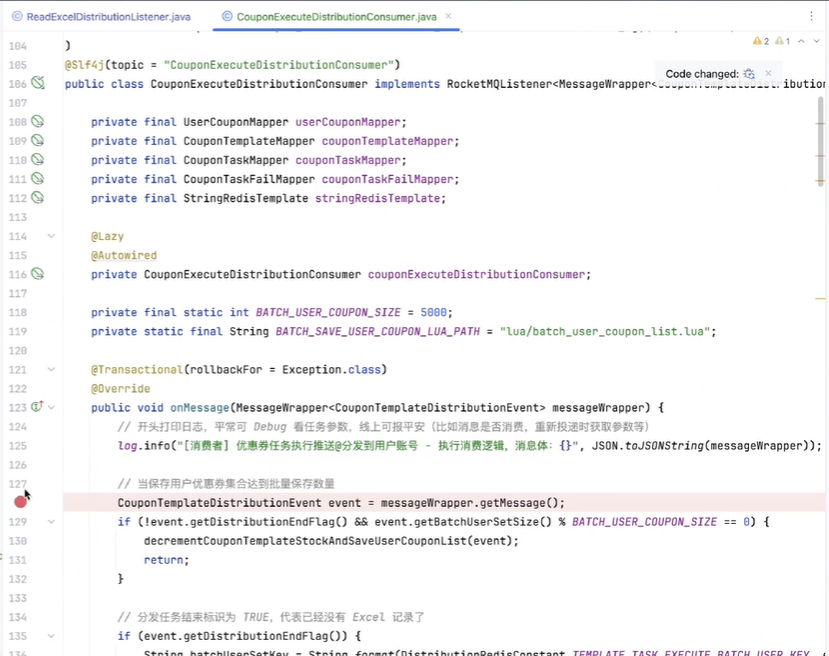

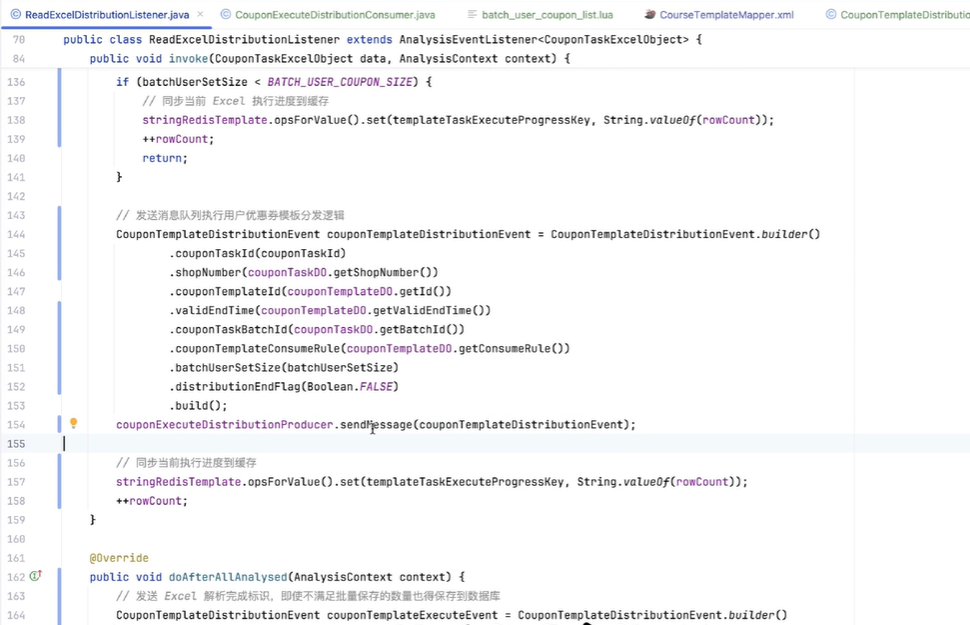

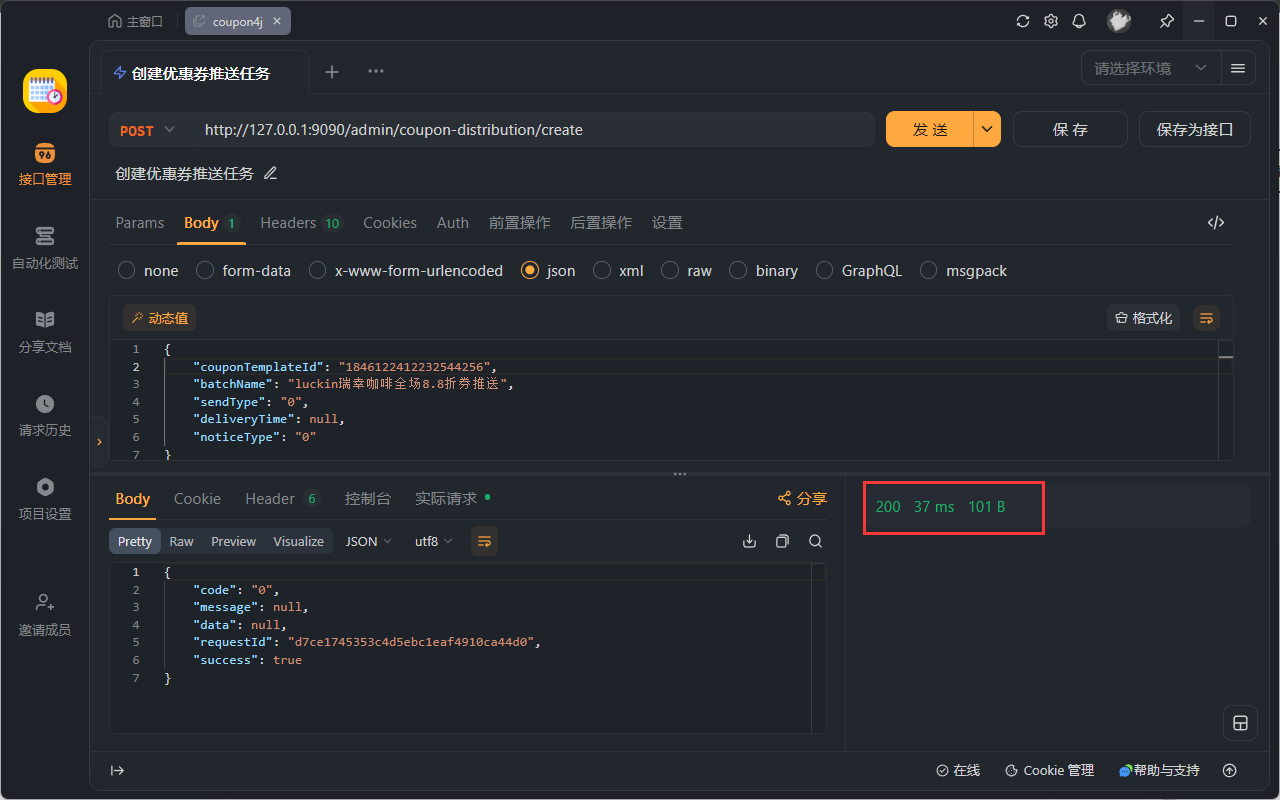

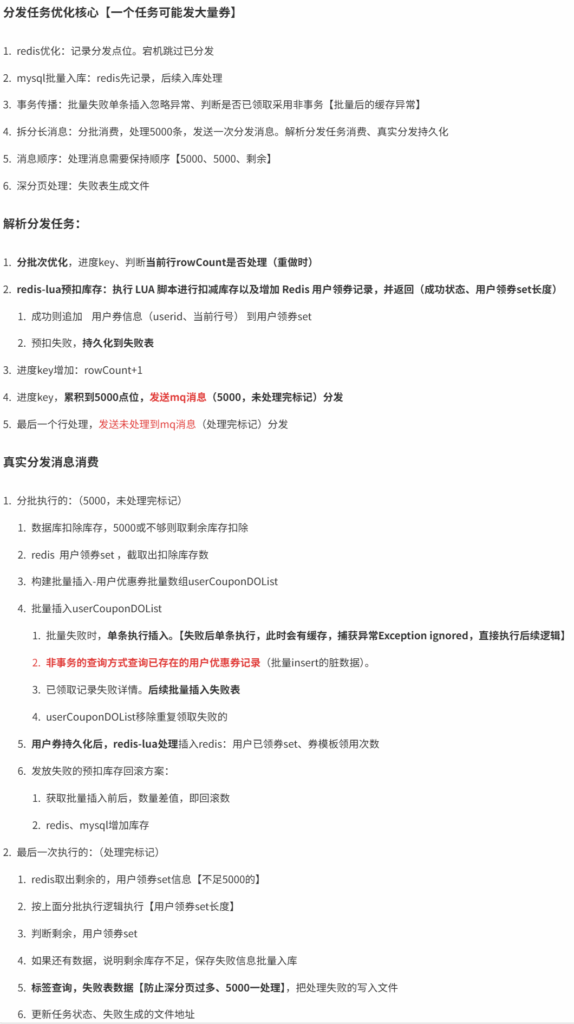

第19小节:开发用户优惠券分发功能(一)

业务背景

因为其实你是有一些信息的缺失的,那在我就是以我个人的经验来看,我们在学一部分内容的时候,首先大家可以把这一个事情然后总结成一些流程,然后整体的总结,而不是上来深入到某些细节方面去,在这里给大家一些建议,包括我们看一些源码,包括学习一些新的技术也都是这个样子。

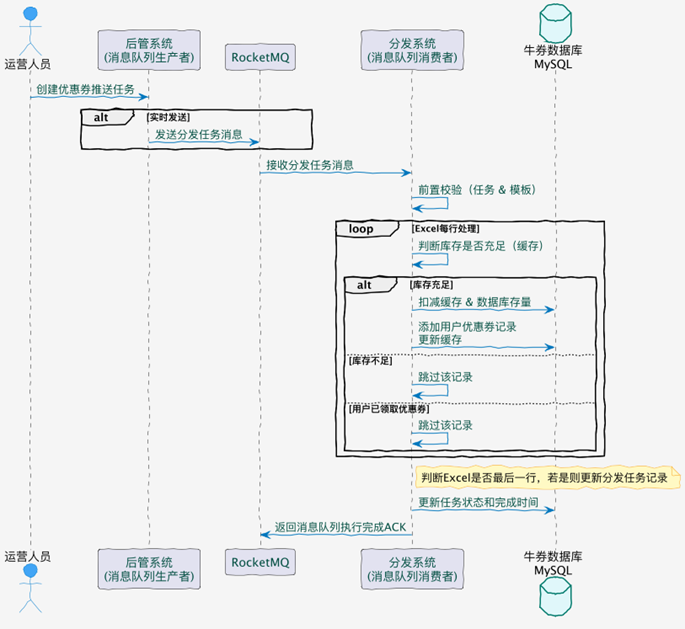

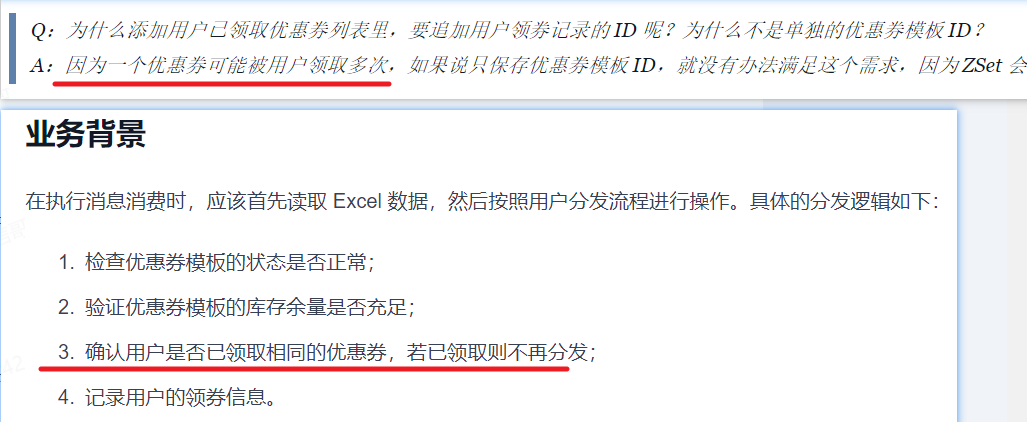

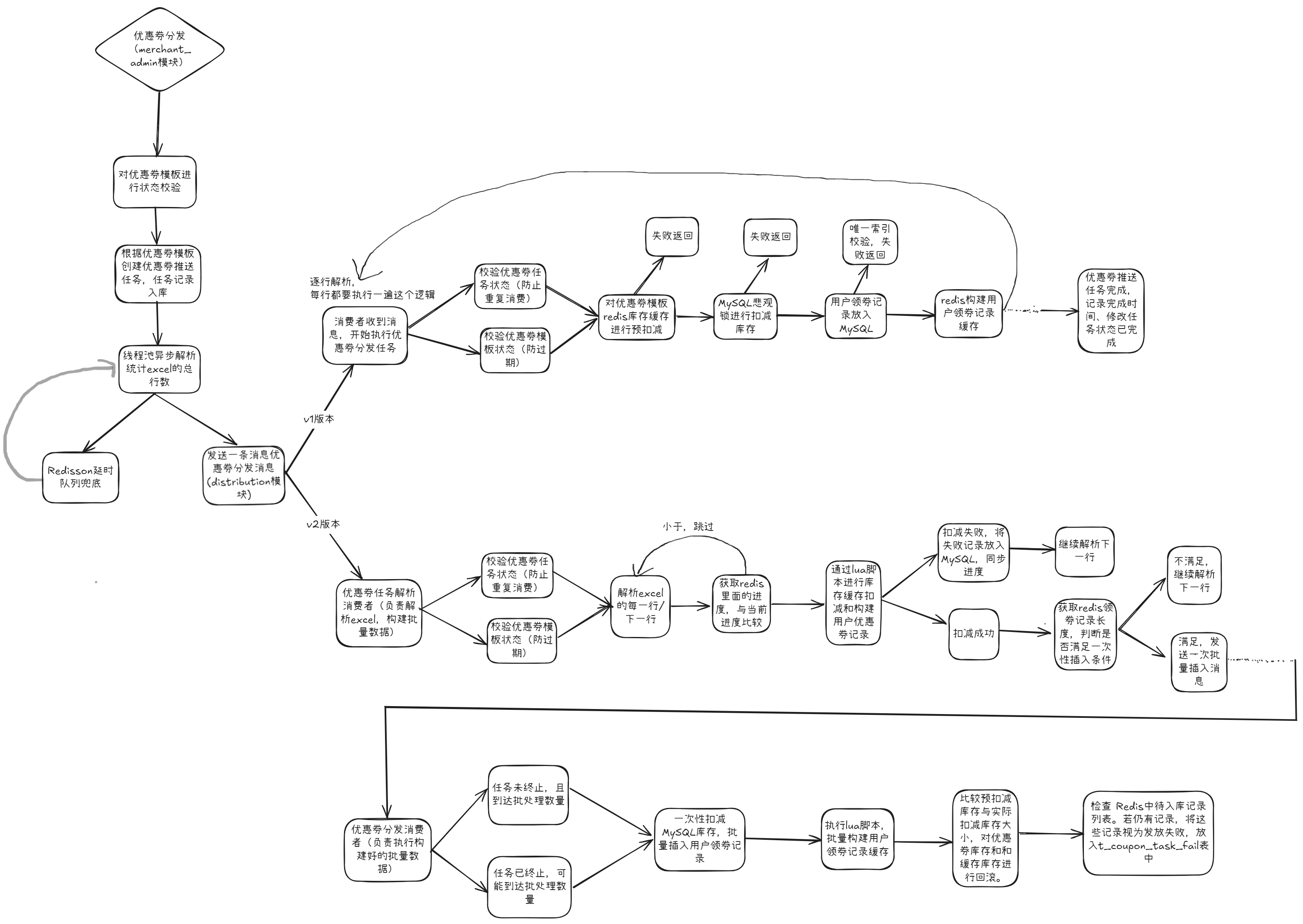

开篇一张图,帮助大家梳理 v1 分发流程关键节点。

首先通过一个时序图的方式,帮大家梳理一下我们分发的一些关键节点。

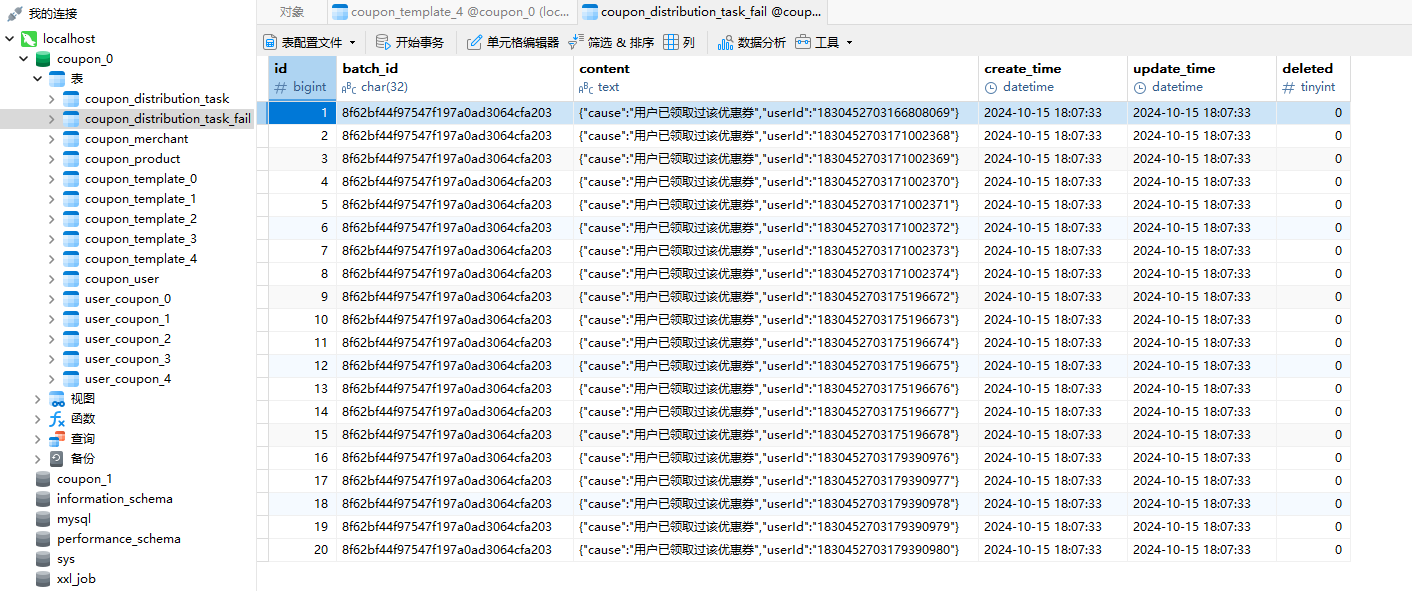

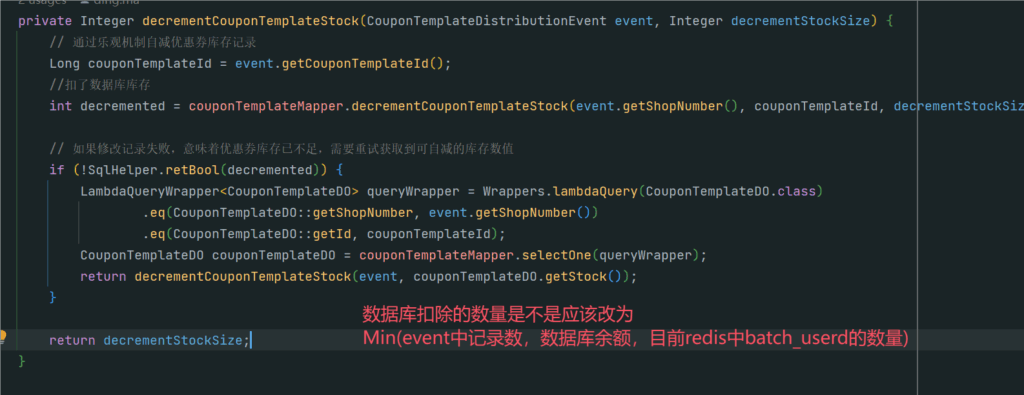

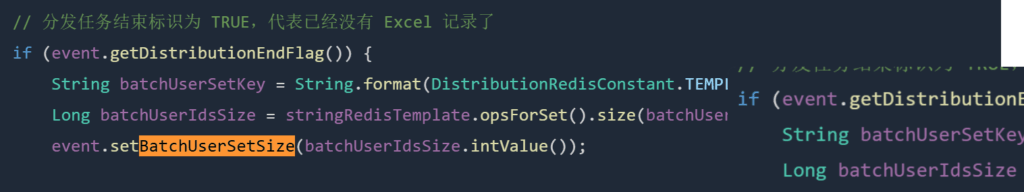

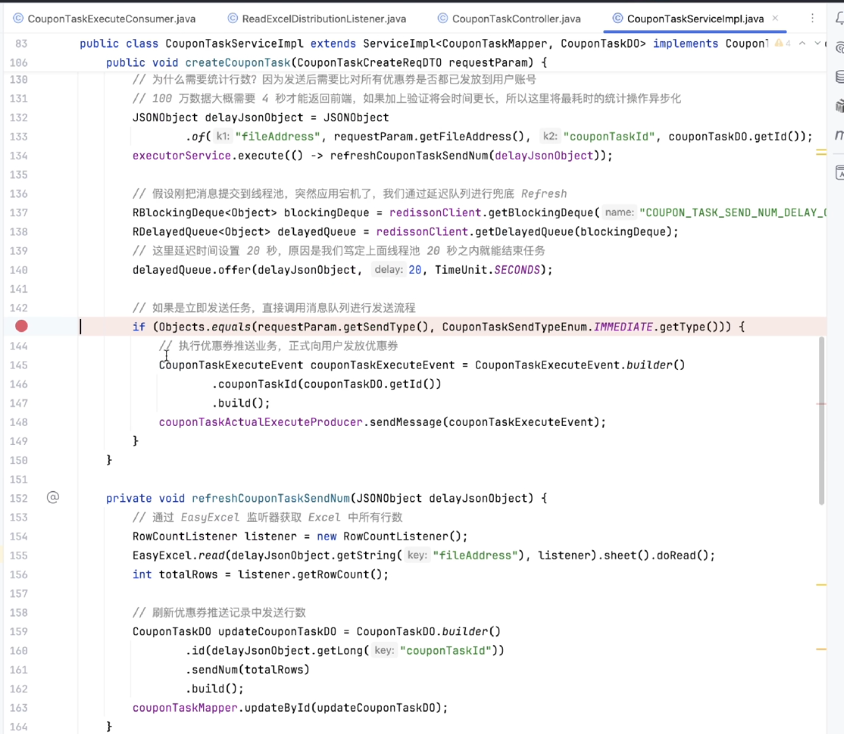

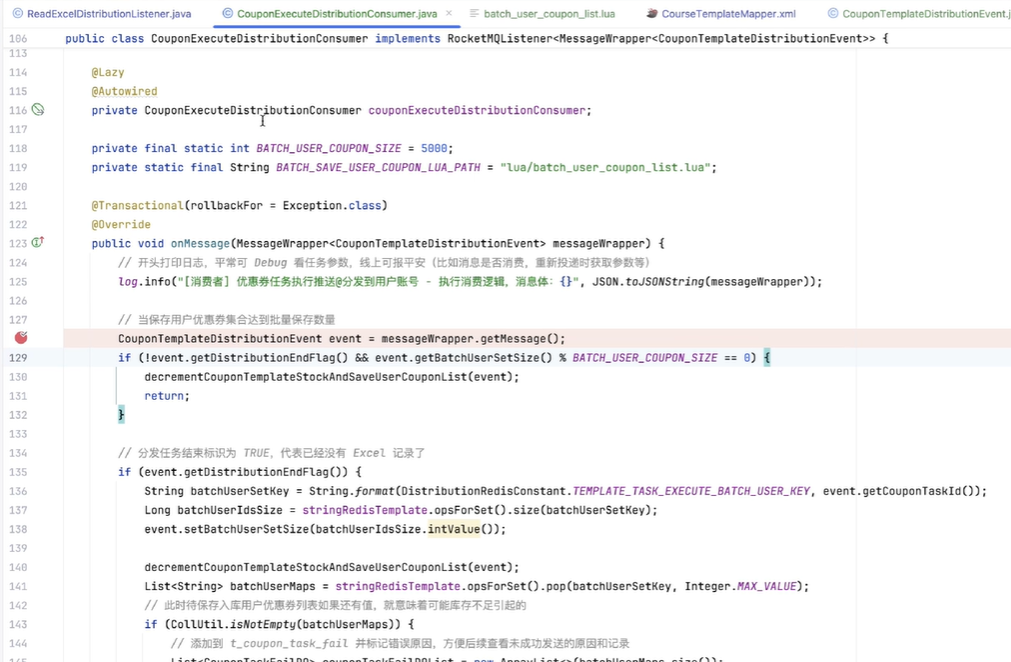

然后发送了之后,它会把这个消息也推送给消息队列。然后消息队列的消费者是在分发系统里面,监听到这个消息之后,首先我们会对它进行一些前置校验。像这一步的话,是在每个系统里面都必不可少的。比如说,如果我们是定时的发送,它有可能用户运营人员觉得“我不需要了”,就把推送任务取消了。如果你没有判断任务的一些状态就去执行,其实系统就有问题。包括:这个模板是不是已经到期了?再或者说,这个模板的优惠券数量还有没有?等等,这些我们都要强制去进行一些判断。

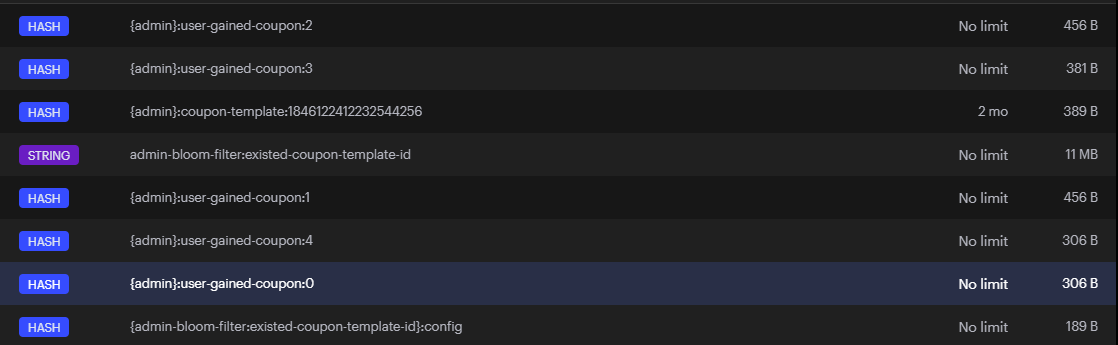

再然后的话,我们本质上是通过优惠券分发,是通过 Excel 去进行处理的。我们去读取 Excel 的时候,它的每一行我们都要做一些处理。我们首先要判断数据库里面是否有我们对应的库存,包括缓存。然后,如果库存充足的情况下,我们会去在缓存和数据库里面进行相应的扣减,并且将用户的领券记录添加到我们的缓存当中。因为后续用户去使用时,我们肯定不能让用户直接去查数据库,对数据库的压力会有一点大。所以首先是加到缓存里面。

如果说当库存不足,或者说用户已经领取完优惠券的情况下,那么我们本条记录跳过即可。

最后,如果我们判断 Excel 已经到了最后一行了,那就证明我们的任务已经结束了。我们就要对分发的任务记录去修改它的一个任务状态,比如说从“执行中”变成“结束”,以及我们什么时候结束的,把它的完成时间也更新一下。

最后,我们把对应的消息队列的一个 ACK 响应返回给消息队列,我们整个流程就结束了。其实这样看起来是比较简单的——当然也是因为我们 V1 节点它的流程会偏简单一点,所以说这么看还好。

本篇文章更多聚焦在分发消息队列消费者,在执行消息消费时,应该首先读取 Excel 数据,然后按照用户分发流程进行操作。

具体的分发逻辑如下:

- 1.检查优惠券模板的状态是否正常;

- 2.验证优惠券模板的库存余量是否充足;

- 3.确认用户是否已领取相同的优惠券,若已领取则不再分发;

- 4.记录用户的领券信息。

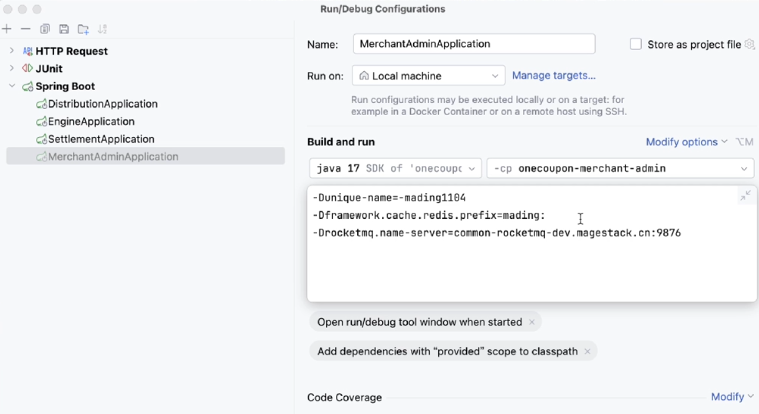

注意,如果前面商家后管服务添加了 vm 参数,分发服务记得也加上,要不然消费不到对应消息队列消息。后管的话,你看在这里面是有一些 VM 参数的。当然我自己在联调的时候,我其实是有一些改动的,大家按照之前我们在文档里面写的就可以了。然后我们这次起来了,分发服务其实也要把对应的一些东西给它加上

Git 分支

20240829_dev_coupon-distribute-v1_easyexcel-cache_ding.ma

数据库表设计

1. 用户优惠券表设计

用户优惠券表设计如下:

CREATE TABLE `t_user_coupon` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';其中有一个字段用于记录用户领取优惠券的次数,以标识这是用户第几次领取。通过设置唯一索引来限制用户的领取次数。因为用户他领取的优惠券,最终是要在数据库表里面进行一个保存的。比如说这里面会记录它的领取时间,以及它的领取次数——因为大家之前在学优惠券模板的时候,其实它里面是有限制用户能够领取多少次的,这个限制就通过我们这里去进行的一个校验。然后还有有效期的开始和结束时间,以及它如果使用的话一个使用时间,还有它的一个来源以及它的一个状态。这个的话会在我们后面章节会用到,默认的话领取完之后是一个“未使用”的状态。然后我们这里面其实还有一些唯一索引,也就是刚才我们讲的领取次数,在数据库做一层兜底。

用户优惠券领取——大家都用过一些像美团、饿了么、京东这些平台——它其实用户的领券量,它的数据量是很大的。所以说我们要对库进行分库分表的一个处理。

然后一般来讲,像这个量级或者说它的这种数据复杂度,说句实在话,只要你没有进行复杂的那些分组排序等逻辑,哪怕数据库表里面它是一个亿级,比如说 1 亿,对吧?其实没有“一般来说”,我们会取一个试用值,这个是没有绝对的好吧?

我上面说的是取决于不同系统的一个量级。这个不是我们在这里去预估的,而是说在系统的运行过程当中你要去评估,然后才能去进行分表,对不对?面试官我们在和他聊的时候,我们就可以说:“在未来多少年,我们的数据量大概推估有多少,然后根据我们表的一个复杂度,我们最终确定为多少张表。”这里我直接设置了 32 张表。

然后刚才我们讲到我们需要分库分表。数据量大,直接分表就行了。但是我们这里为什么要考虑分库?分库是因为对数据库用户领取的话,它的对数据库的操作还是蛮频繁的。分表是主要解决数据量大、查询慢的问题;分库的话,就是解决并发大、然后单库扛不住的问题;因为我们的分配策略和优惠券模板基本上是相同的,所以说我们这里面直接去加就好了。然后这是我们的用户优惠券表,然后可以看到都是采用哈希的方式,大家应该比较熟悉了。然后的话,就是我们去对应的数据库,创建我们对应的数据库表

2. 用户优惠券分库分表设计

由于用户优惠券记录的数据量非常大,需要对该表进行分库分表处理。不同于优惠券模板数据可以推衍估算,我们将直接分为 32 张表,以确保单表数据量保持在亿级以下,从而避免性能压力。

考虑到大量用户频繁领取优惠券导致写入操作较为频繁,因此也需要进行分库。分片策略与优惠券模板相同,采用 Hash 方式进行分库分表。

然后大家这里面有两点注意事项:

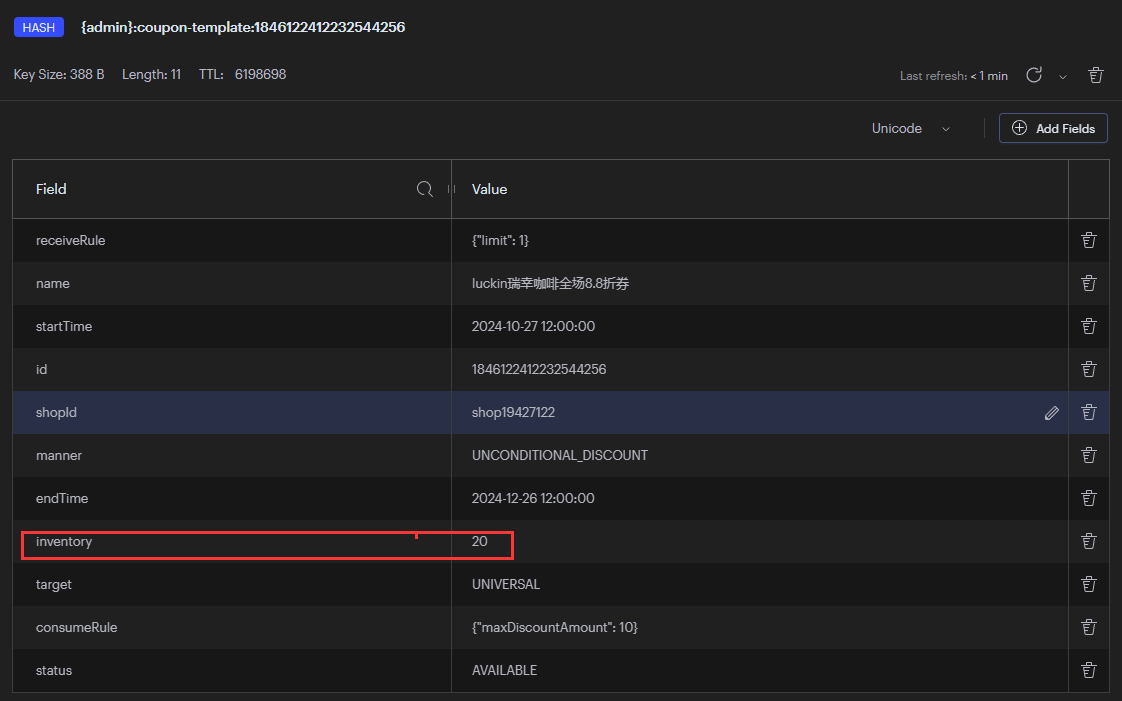

首先第一点的话,就是这个结束时间。因为我们现在是 25 年的 6 月份,所以说如果是 25 年默认时间好像是 25 年 9 月份——这个是我当时随便写的,26 年之前都可以。大家在学的时候,如果发现当前的时间已经大于这个时间,请大家改一下,要不然的话你创建完模板的时候它就会被过期。因为我们优惠券模板过期了之后是自动去给它销毁的,好吧?

然后第二个的话,就是它的库存量。因为我们接下来我们去执行,我们应该是 5000 条记录,这里我设置 5001 的一个库存,方便大家去看一下。好吧,这里的话我们直接执行。

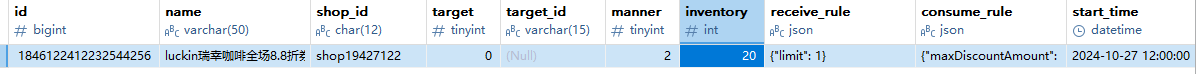

执行完了之后,我们去看一下我们的数据库表。如果按照我们的分片规则,我们的优惠券模板应该在我们的一库和第十五张表里面。我们把 ID 给复制出来,大家可以看到我们的库存是 5001。然后我们相同的其实是相同的是模板。

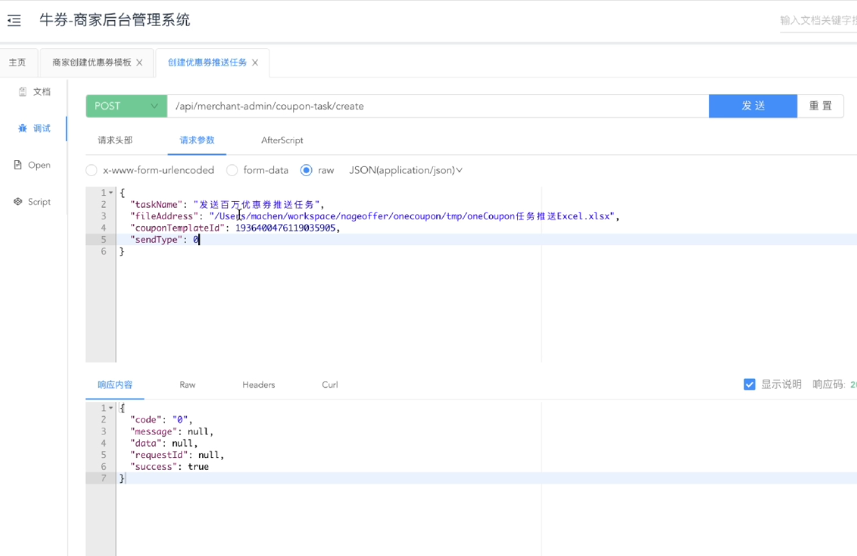

这个是我们对应的优惠券推送——创建分发任务这一块。把优惠券 ID 改一下。

然后这里面刚才我们有说,它是有两种发送方式:第一种的话就是立即发送,对吧?第二种的话是定时发送。如果是定时发送的话,这里 type 是 1,然后下面还有一个 systemTime。这里我们就不演示定时了,这个功能肯定是好的,然后我们这里面直接实时推送就好。

然后我们这里面……我看看有没有打debug?稍等。在第一步的话,它应该是在 service 里面有的。然后第二步的话应该是在我们的controller 里面。OK,没问题,然后我们点一下发送。

然后在这里面,因为判断我们的类型的话它是 0,所以说是立即发送。我们通过消息队列的方式,然后发送给我们对应的分发服务。然后这里面就到这里了。

# 数据源集合

dataSources:

# 自定义数据源名称,可以是 ds_0 也可以叫 datasource_0 都可以

ds_0:

dataSourceClassName: com.zaxxer.hikari.HikariDataSource

driverClassName: com.mysql.cj.jdbc.Driver

jdbcUrl: jdbc:mysql://127.0.0.1:3306/one_coupon_rebuild_0?useUnicode=true&characterEncoding=UTF-8&rewriteBatchedStatements=true&allowMultiQueries=true&serverTimezone=Asia/Shanghai

username: root

password: root

ds_1:

dataSourceClassName: com.zaxxer.hikari.HikariDataSource

driverClassName: com.mysql.cj.jdbc.Driver

jdbcUrl: jdbc:mysql://127.0.0.1:3306/one_coupon_rebuild_1?useUnicode=true&characterEncoding=UTF-8&rewriteBatchedStatements=true&allowMultiQueries=true&serverTimezone=Asia/Shanghai

username: root

password: root

rules:

- !SHARDING

tables: # 需要分片的数据库表集合

t_coupon_template: # 优惠券模板表

# 真实存在数据库中的物理表

actualDataNodes: ds_${0..1}.t_coupon_template_${0..15}

databaseStrategy: # 分库策略

standard: # 单分片键分库

shardingColumn: shop_number # 分片键

shardingAlgorithmName: coupon_template_database_mod # 库分片算法名称,对应 rules[0].shardingAlgorithms

tableStrategy: # 分表策略

standard: # 单分片键分表

shardingColumn: shop_number # 分片键

shardingAlgorithmName: coupon_template_table_mod # 表分片算法名称,对应 rules[0].shardingAlgorithms

t_user_coupon:

actualDataNodes: ds_${0..1}.t_user_coupon_${0..31}

databaseStrategy:

standard:

shardingColumn: user_id

shardingAlgorithmName: user_coupon_database_mod

tableStrategy:

standard:

shardingColumn: user_id

shardingAlgorithmName: user_coupon_table_mod

shardingAlgorithms: # 分片算法定义集合

coupon_template_database_mod: # 优惠券分库算法定义

type: CLASS_BASED # 根据自定义库分片算法类进行分片

props: # 分片相关属性

# 自定义库分片算法Class

algorithmClassName: com.nageoffer.onecoupon.distribution.dao.sharding.DBHashModShardingAlgorithm

sharding-count: 16 # 分片总数量

strategy: standard # 分片类型,单字段分片

coupon_template_table_mod: # 优惠券分表算法定义

type: CLASS_BASED # 根据自定义库分片算法类进行分片

props: # 分片相关属性

# 自定义表分片算法Class

algorithmClassName: com.nageoffer.onecoupon.distribution.dao.sharding.TableHashModShardingAlgorithm

strategy: standard # 分片类型,单字段分片

user_coupon_database_mod:

type: CLASS_BASED

props:

algorithmClassName: com.nageoffer.onecoupon.distribution.dao.sharding.DBHashModShardingAlgorithm

sharding-count: 32

strategy: standard

user_coupon_table_mod:

type: CLASS_BASED

props:

algorithmClassName: com.nageoffer.onecoupon.distribution.dao.sharding.TableHashModShardingAlgorithm

strategy: standard

props:

# 配置 ShardingSphere 默认打印 SQL 执行语句

sql-show: true3. 创建用户优惠券表 SQL

进入 one_coupon_rebuild_0 数据库,执行下述 SQL。

CREATE TABLE `t_user_coupon_0` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_1` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_2` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_3` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_4` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_5` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_6` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_7` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_8` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_9` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_10` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_11` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_12` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_13` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_14` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_15` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';进入 one_coupon_rebuild_1 数据库,执行下述 SQL。

CREATE TABLE `t_user_coupon_16` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_17` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_18` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_19` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_20` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_21` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_22` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_23` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_24` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_25` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_26` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE

) ENGINE=InnoDB AUTO_INCREMENT=1815640588360376337 DEFAULT CHARSET=utf8mb4 COMMENT='用户优惠券表';

CREATE TABLE `t_user_coupon_27` (

`id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',

`user_id` bigint(20) DEFAULT NULL COMMENT '用户ID',

`coupon_template_id` bigint(20) DEFAULT NULL COMMENT '优惠券模板ID',

`receive_time` datetime DEFAULT NULL COMMENT '领取时间',

`receive_count` int(3) DEFAULT NULL COMMENT '领取次数',

`valid_start_time` datetime DEFAULT NULL COMMENT '有效期开始时间',

`valid_end_time` datetime DEFAULT NULL COMMENT '有效期结束时间',

`use_time` datetime DEFAULT NULL COMMENT '使用时间',

`source` tinyint(1) DEFAULT NULL COMMENT '券来源 0:领券中心 1:平台发放 2:店铺领取',

`status` tinyint(1) DEFAULT NULL COMMENT '状态 0:未使用 1:锁定 2:已使用 3:已过期 4:已撤回',

`create_time` datetime DEFAULT NULL COMMENT '创建时间',

`update_time` datetime DEFAULT NULL COMMENT '修改时间',

`del_flag` tinyint(1) DEFAULT NULL COMMENT '删除标识 0:未删除 1:已删除',

PRIMARY KEY (`id`),

UNIQUE KEY `idx_user_id_coupon_template_receive_count` (`user_id`,`coupon_template_id`,`receive_count`) USING BTREE,

KEY `idx_user_id` (`user_id`) USING BTREE